۹۱/۱۲/۲۶

ریاضیات یادگیری

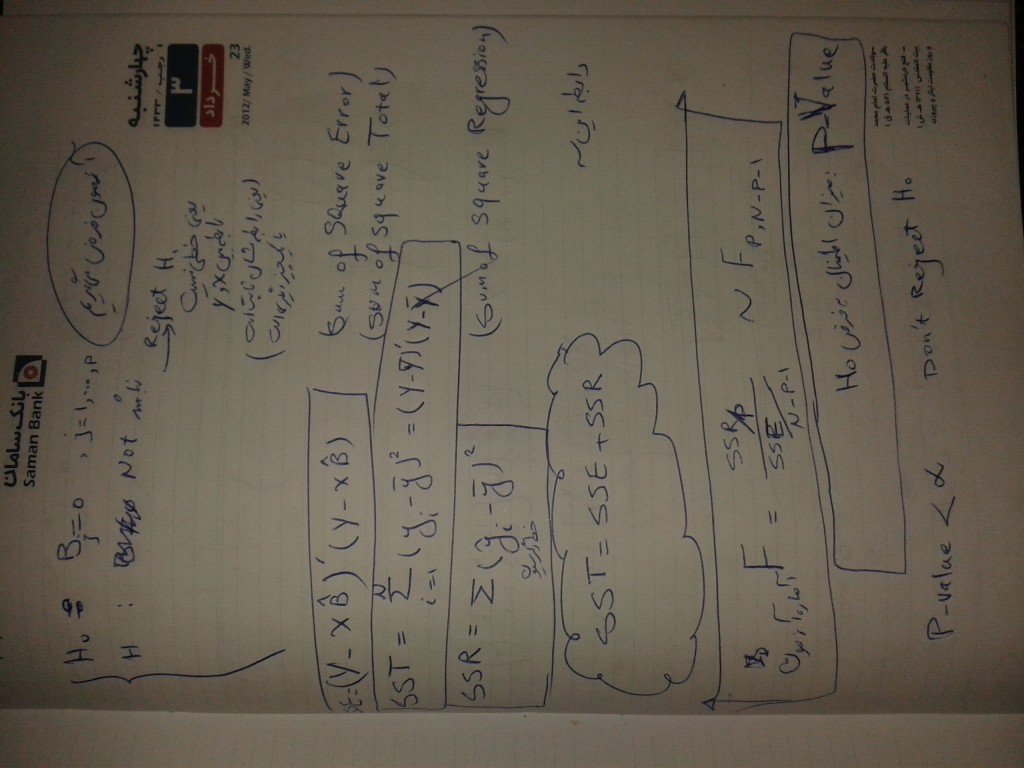

چهار شنبه ۹۲/۳/۴ کلاس حضوری امتحان از رگرسیون میان ترم گرفته می شود

آزمون فرض – فاصله اطمینان بایستی به صورت پیش فرض بدونید

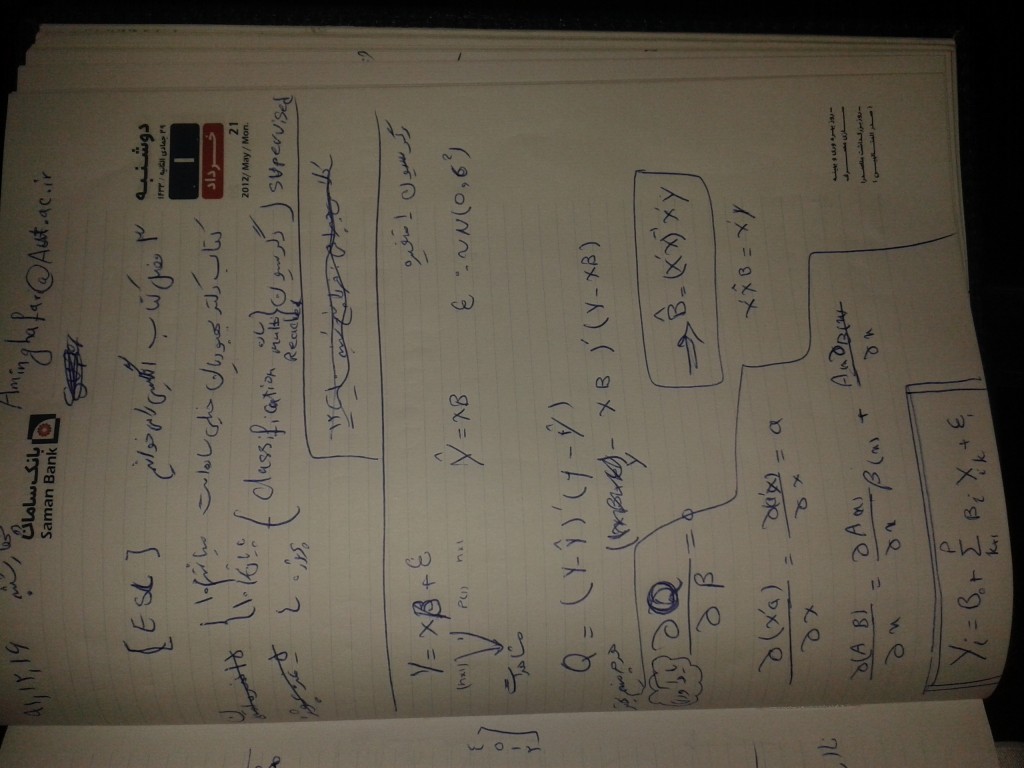

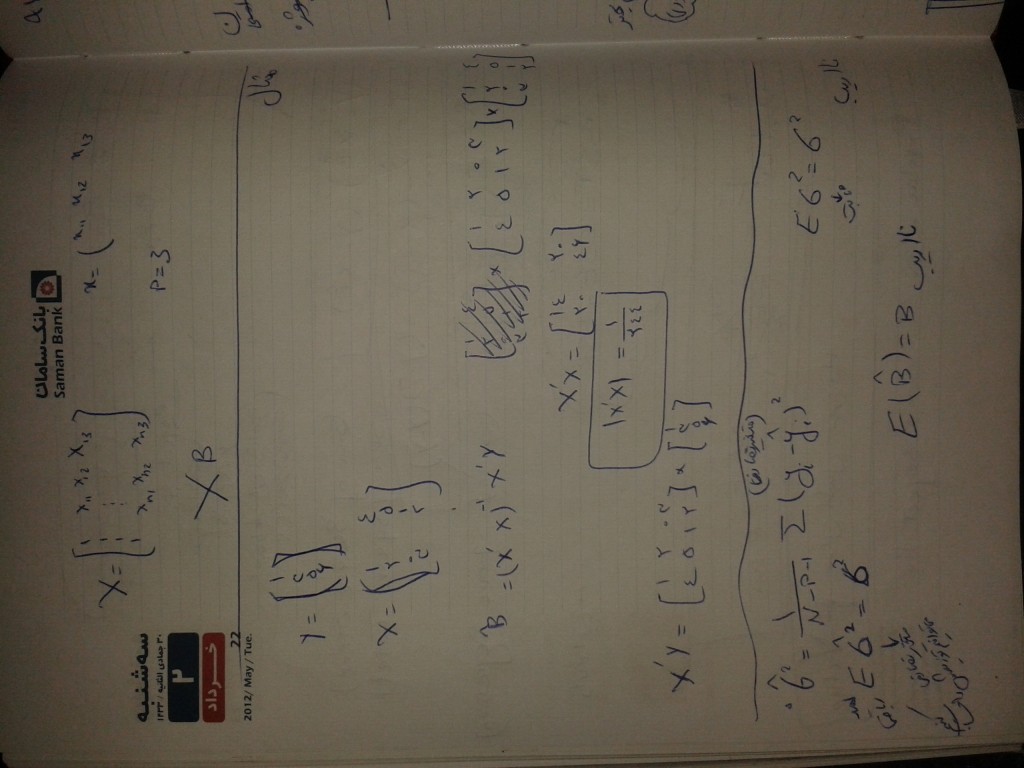

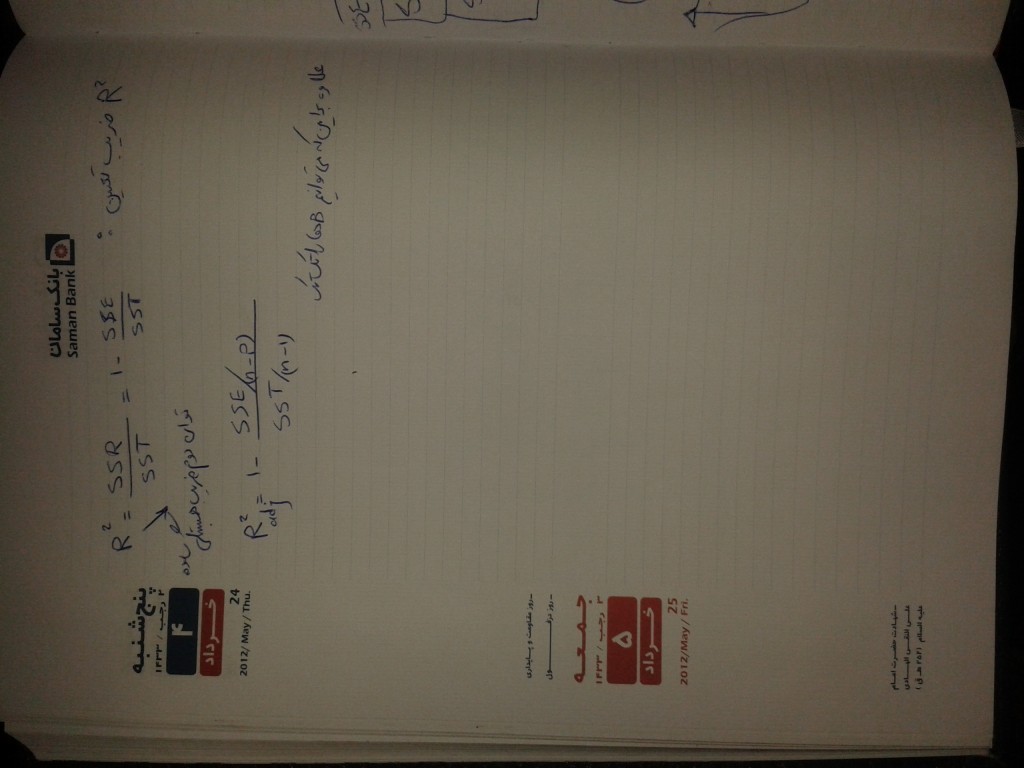

رگرسیون چند گانه :

حالتی که p تا x داریم

x ها میتونن تبدیلی از بقیه x ها باشند

نا اریب هست

یک کمیت داریم MSE که یک جور ریسک هست ( امید تابع زیان )

Too many Predictors

۱- روش subset selection زیر مجموعه ای از متغیر ها را انتخاب میکنیم

۲- Cross Validation

۳- روش Shrinkage Methods ضرایب (Beta) را کوچک می کنیم به سمت صفر

بهتر است که نا اریب باشد.

نا اریب باشد یعنی خطا کم باشد ، واریانس کم باشد، امیدش با خودش برابر باشد.

همه x ها را در مدل می گذاریم ولی یک ضریب براشون می گذاریم

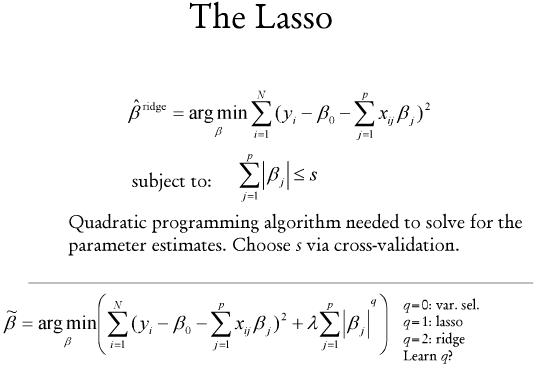

یکی از روش های شرینکیج Ridge Regression است

روش انقباظی

مجموع مربعات خطا می نیمم می کنیم با شرط اینکه جریمه در نظر میگیریم

از روش لاگرانژ

مزیت های Ridge :

مجموع توان ۲ پارامترها خیلی بزرگ نمی شود

لاندا را می توان با استفاده از روش Cross Validation محاسبه می کنیم و باید داده ها را باید استاندارد کنیم

رگرسیون لاسو هم مانند رگرسون ریج هست با این تفاوت که سیگمای بتا j ها به توان ۲ کمتر از S

سیگمای قدر مطلق بتا ها را در نظر می گیریم کمتر از S

رگرسیون لاسو تکنیک جدیدی است ولی ریج خیلی قدیمی است