سوال اساسی : نسبت ATMS و ATIS

در ATMS : مدیریت تقاطع ها

در ATIS مدیریت اطلاع رسانی کاربران ، خبرگان

معماری ارتباط بین ATMS و ATIS را می تواند برقرار کند

معماری سراسری و معماری منطقه ای داریم

در مبحث استاندارد سازی به چند نکته اشاره می کنیم

۱- در حوزه مفاهیم : در سطح ملی بایستی استاندارد سازی مفاهیم شود

۲- استاندارد سازی در حووزه سخت افزار ها

۳- استاندارد سازی نرم افزاری

استاندار های بازار یابی

استاندارد ها به صورت قوانین می توانند تبدیل شوند

سازمان استاندارد در حوزه های IT و ITS استاندارد های خوبی داریم

TC 204 در ISO به ITS اختصاص دارد – ولی در ایران نداریم

جا دارد که در حوزه های خدمات ITS این استاندارد ها را تکمیل کنیم

TC204 مرجع اساسی جمع بندی سیستم های ITS هست

روی اقلام مختلف ITS استاندارد های مختلفی را داریم

۱۳۷ مورد موسسه ایزو استاندارد های مختلف در حوزه ITS قرار داده است

تمرین : ( مهلت تا ۶ دی )

فرم های آپلود شده در LMS

پرسشنامه – مصاحبه برای نیازمندی ها

با آگاهی از کاربر

معماری اصل است

معماری به ما کمک می کند خطا به حداقل برسد ، ریسک پایین بیاد

الگوی های استاندارد از پیش تعیین شده پیش برویم

ارتباط برقرار کردن بین سیستم ها برسیم

در یکی از بحث های مهم استاندارد های تدوین معماری هست

برای تدوین استاندارد های معماری بر اساس استاندارد مناسب با توجه به جنبه های

موثر در معماری

کتاب هم به چاپ رسیده توسط موسسه توسعه معماری

تاکید مضاعف بر توسعه معماری : حوزه های مختلف را باید بتوانیم پوشش بدهیم

شروع کار از سطوح مطالعاتی است

تاکید بر فرایند بازگشت پذیر بودن

زیر ساخت های

در قالب Teamwork ها در بخش های صاحب نفوذ

پیدا کردن راه حل های مشترک

policy نویسی

Strategic plan on ITS

در کلیه بخش های ITS نیازمند اول Policy های مربوط به بخش را پیدا کنند و سپس

تعریف کار در حوزه انجام شود

برای پشتیبانی از Policy چه خدماتی باید ارائه شود

بر روی آن سرویس های کاربر را بتواند پوشش دهد

در حوزه آینده پژوهی باید بسیار کار شود

ITS effisient

Green ITS

Feature ITS

امتحان :

۱- خدمات ITS (زیر سیستم ها – )

۲- الگوریتم ( تخصیص ترافیک – شمارش مسیر ها – الگوریتم لاگرانژ – مطابقت دو طرفه ) در حد مباحث اسلاید ها

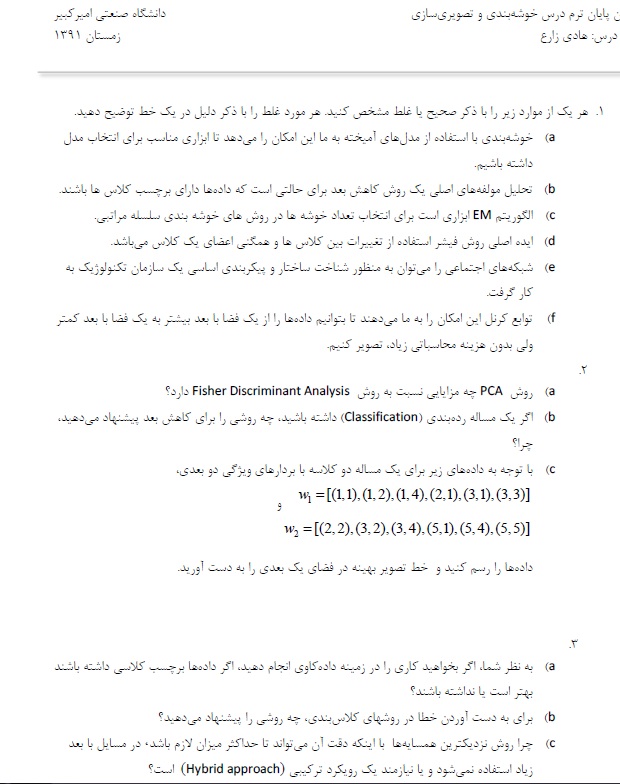

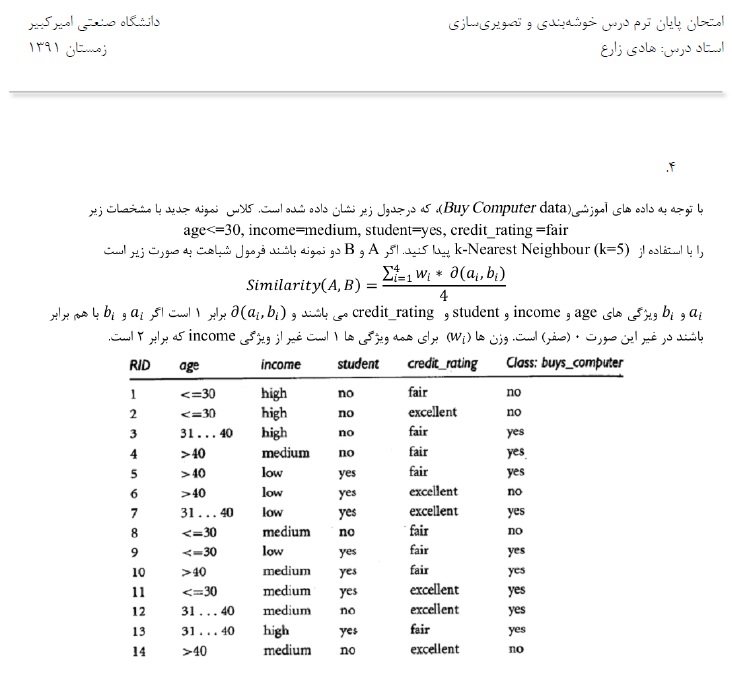

خلاصه جلسه جبرانی خوشه بندی ساعت ۵ تا ۶:۳۰ دکتر زارع ۹۲/۰۹/۲۵

Classification

فیشر :

با استفاده از توزیع گوسی روش فیشر را بدست آورد در بحث Pattern Recognition

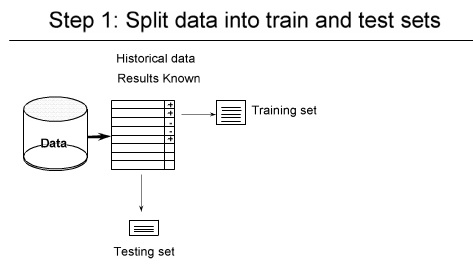

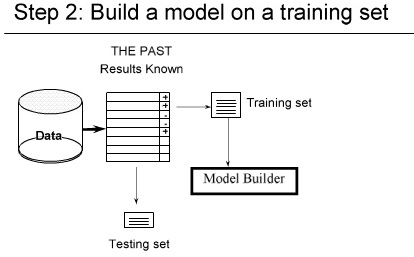

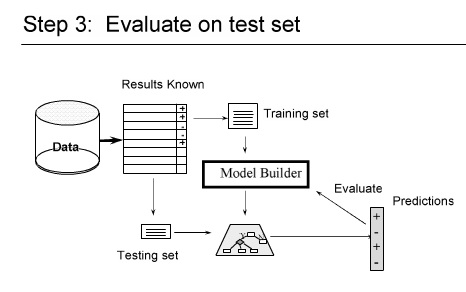

داده ها را به دو دسته train و test تقسیم می کنیم

اگر بتوانیم یک جدا ساز ساده تعیین کنیم برای داده های تست عملکرد خوبی داشته باشیم

nearest Neighbor در صورت اضافه شدن داده جدید ،

یک پیش پردازش برای کاهش بعد انجام می دهیم

و معمولا از Feature Selection برای بیرون انداختن داده های نامربوط استفاده می کنیم

برای تشخیص پارامتر های موثر

از یکی از این سه روش می توانیم استفاده کنیم

-Forward Selection

– Backward Elimination

– Bi-Directional search

در بحث Distanse های مختلفی می توانیم استفاده کنیم ( اقلیدسی – منهتن – ماهالونوبیس )

دو تا اسم داریم Peter , Piotr

از اسم اول با ۳ عملگر می توانیم به اسم دوم برسیم

————————————

فایلهای زیر آپلود شد

Clustering Final exam

sharifi test

intro_SVM_new

classification – part 4

———————————-

———————————-

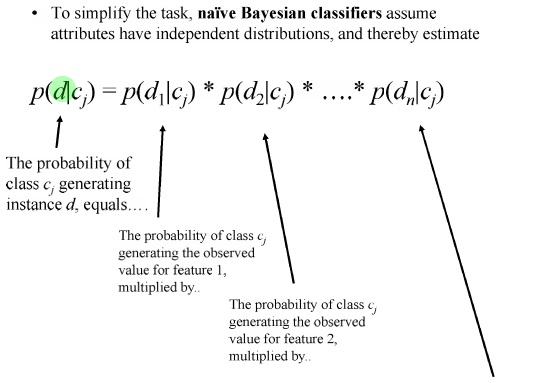

Naive Bayes رو معمولا بر اساس گراف می کشند

نایو بیز نسبت به Future های نامربوط حساس نیست

چون در واقع ویژگی ها از هم مستقلند اثر یک ویژگی از بین می رود

آیا می شود روش Naive Bayes را بهتر کرد ؟ بله

مزایا و معایب روش Naive Bayes:

————————————–

در امتحان نمی آید

SVM : Support Vector Machine

ماشین بردار پشتیبان

آقای vladimir vapnik مطرح کرد ۱۹۸۰

Statistical Learning Theory

Dataset – MNIC

error rate بسیار کمی داشت

اولین بار روش Kernel را با SVM مطرح کردند

اگر دو کلاس داشته باشیم و بتوانیم با یک خط جدا کنیم پس بی نهایت خط دیگر می توانیم رسم کنیم

بهترین خط را کدام در نظر بگیریم

دو خط مرزی را در نظر می گیریم و مرز تصمیم گیری را در میانگین این دو خط مرزی در نظر می گیریم

Margin را باید Maximize کنیم

KKT Conditions

سر امتحان

ماشین حساب بیارید

دندوگرام باید بکشید

K-means

GMM

PCA

Fisher

روشهای classification

Naive Bayes و K-nearest Neighbor را باید بلد باشد

h.zare@ut.ac.ir

مقاله ها را به این ایمیل بفرستید

تا ۱۵ بهمن تاریخ نحویل پروژه هست

نمونه سوال سال تحصیلی ۹۰ – ۹۱

دانشگاه صنعتی امیرکبیر

دانشکده مهندسی کامپیوتر و فناوری اطلاعات

امتحان درس مهندسی و ساخت سیستمهای تجارت الکترونیک

بخش الف) یک مرکز داده قصد دارد تا به مشتریان خود, سرویس دهنده مجازی (Virtual Private Server-VPS) عرضه نماید. در این نوع از خدمات زیرساخت, به کمک تکنولوژی های نرم افزاری از مجموعه مشخصی از امکانات و تجهیزات حقیقی شامل سرویس دهنده حقیقی (حاوی حافظه جانبی, حافظه اصلی, پردازش گر و …) , عرض باند اینترنتی و سایر موارد، سرویس دهنده های مجازی متعدد و با ظرفیت های مختلف و قابل تعریف مبتنی بر خصوصیات نیاز متقاضی, ایجاد و با استفاده از ابزار مدیریتی مستقل در اختیار او قرارداده می شود. مشتریان می توانند از میان پیکره بندی های تعیین شده قبلی, سرویس دهنده مورد نیاز خود را انتخاب نموده و یا ایجاد سرویس دهنده ای را مبتنی بر نیاز خاص خود درخواست نمایند.

۱) با فرض وجود حداقل نقش های خریدار، فروشنده، بانک به عنوان مرجع پرداخت الکترونیکی، ثبت احوال به عنوان مرجع احراز هویت افراد حقیقی، سیستم تجارت الکترونیکی و موسسه اعتبارسنجی مشتریان، فرآیند هر یک از فعالیت فروش الکترونیکی VPS از پیش آماده و فروش الکترونیکی VPS اختصاصی، را طراحی نمایید.

۲) به غیر از فعالیت های ذکر شده در بند قبل، دو فعالیت تجاری و دوفعالیت غیرتجاری دیگر را که مکمل یا مرتبط فعالیت های بند قبل باشند، فقط نام برده و نوع آنها را بلحاظ موضوعی مشخص نمایید.

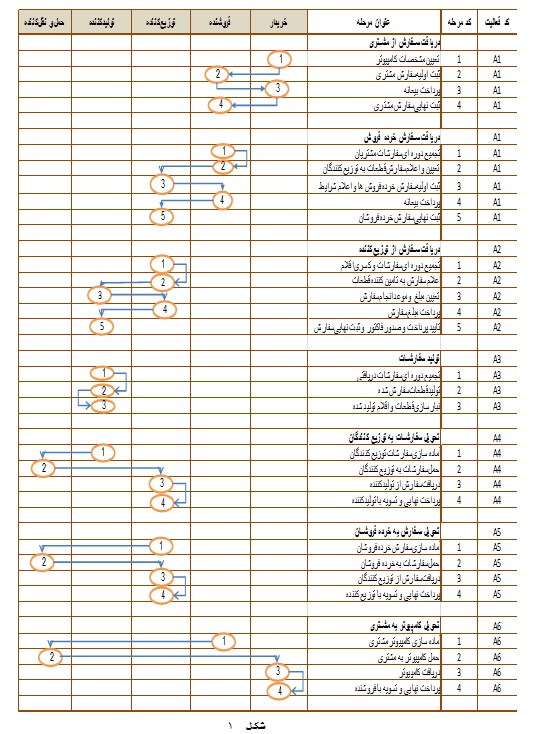

بخش ب) در شکل (۱)، جریان های کاری مربوط به فعالیت های یک زنجیره تامین کامپیوتر به صورت سفارشی برای مشتریان آورده شده است. با فرض آن که خریدار یا مشتری عنصری خارج از زنجیره تلقی گردد، مطلوبست:

۱) مدل های PGFD سطوح فرآیند و کل زنجیره تامین

۲) طراحی مجدد جریان های گردش کار برای فعالیت های زنجیره با فرض آن که هر یک اعضای زنجیره (فروشنده، توزیع کننده و تامین کننده) دارای یک سامانه تجارت الکترونیکی مجزا و مستقل باشند.

۳) طراحی نمودارهای LGFD سطح گردش کار الکترونیکی و PGFD سطح صفر مربوط به سیستم تجارت الکترونیک هر یک از سامانه های تجارت الکترونیکی زنجیره

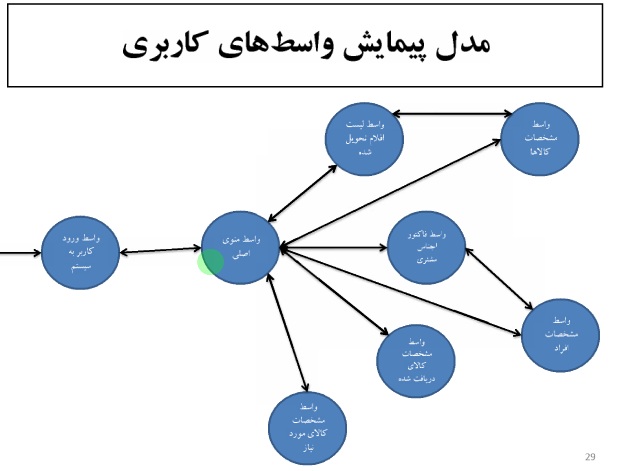

۴) با توجه به فهرست جریان های ورودی و خروجی بدست آمده در سئوال قبلی، نمودار پیمایش واسط های کاربر برای هر یک از نرم افزار سیستم تجارت الکترونیک زنجیره مورد نظر را طراحی نمائید.(توجه: در صورت نیاز می توانید به مجموعه عناوین حاصل، موارد دیگری را حسب نیاز و جهت تکمیل نمودار پیمایش اضافه نمائید.)

بخش (ج): با توجه مراحل آورده شده در فرآیندهای کاری الکترونیکی شده مربوط به بخش قبل و سمینارهای ارائه شده در کلاس مشخص نمایید که در انجام یا الکترونیکی نمودن کدامیک از مراحل آورده شده در جریان های کاری, می توان از ایده ها، مدل ها و مطالب ارائه شده در مقالات سمینارهای کلاسی, بهره گرفت؟ ذکر کاربرد دو مورد از مقالات ارائه شده در سمینارهای کلاسی کافی است. (برای هر یک حداکثر در چهار سطر)

—-

نمونه سوال سال تحصیلی ۸۹- ۹۰

دانشگاه صنعتی امیرکبیر

دانشکده مهندسی کامپیوتر و فناوری اطلاعات

امتحان درس مهندسی و ساخت سیستمهای تجارت الکترونیک

بخش الف) مرکز تحقیقات پردازش های فوق سریع دانشگاه صنعتی امیرکبیر موفق شده تا با ایجاد یک ابر رایانه خوشه ای (Super Cluster) امکان عرضه خدمات پردازش فوق سریع به سایر سازمان ها ، دانشگاه ها و اشخاص حقیقی را فراهم آورد. همچنین این مرکز قادر است تا علاوه بر ارائه خدمات پردازش فوق سریع، بنابر سفارش سازمان های متقاضی برای آنها اقدام به تولید ابر رایانه نماید. این مرکز تصمیم گرفته تا برای ارائه این خدمات شرکتی با ماهیت تجاری را در مرکز رشد دانشگاه تاسیس نماید.

۱) فعالیت های تجاری ممکن و چهار فعالیت فرعی شرکت مورد نظر را مبتنی بر محصولات مشخص شده برای آن نام ببرید.

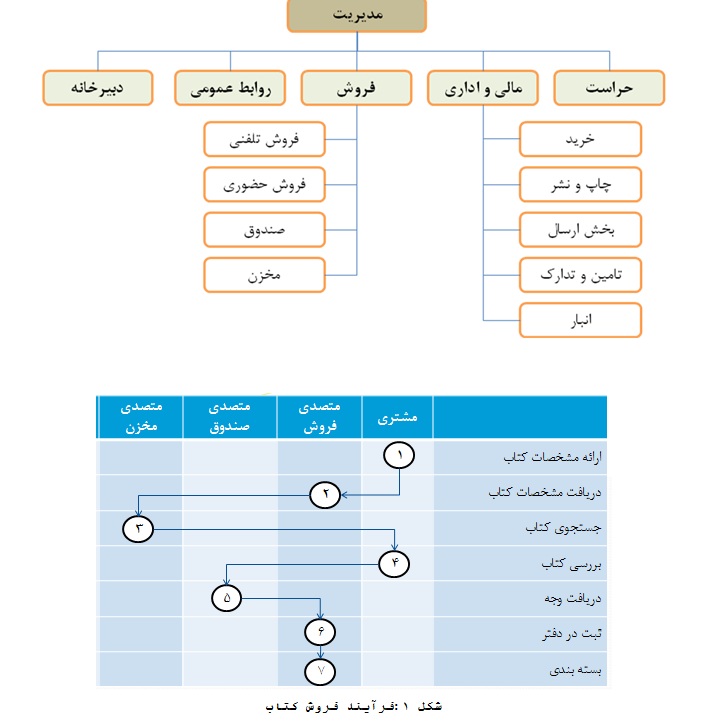

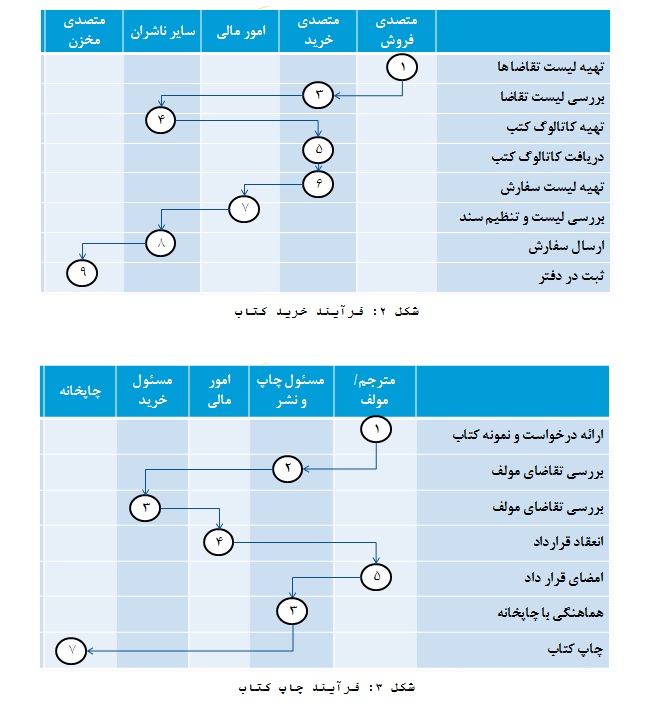

۲) با طراحی یک چارت سازمانی که اجزای آن بر مبنای وظیفه تعیین شده باشد، مدل جریان کار سازمانی جهت ارائه دو فعالیت تجاری عنوان شده در سئوال قبل را با فرض عدم وجود سیستم الکترونیکی مشخص و به صورت ماتریس گردش کار ترسیم نمائید.(در پشت صفحه)

۳) فرض وجود سیستم الکترونیکی در سئوال قبل، چه ابعادی از مدل جریان های کاری طراحی شده را تحت تاثیر قرار خواهد داد؟ آیا می توان به در مورد شرکت مذکور، به یک سازمان تمام الکترونیک(Virtual Organization) دست یافت؟

بخش ب) در بخش ضمیمه، جریان های کاری مربوط به سه فعالیت فروش، خرید و چاپ کتاب در یک بنگاه انتشاراتی آورده شده است. مطلوبست:

۴) تحلیل جریان های عمومی بنگاه مذکور در لایه فرآیندهای کاری PGFD-LGFD منظورشه

۵) تحلیل جریان های عمومی کل بنگاه در لایه زمینه (سطح صفر)

۶) طراحی مجدد جریان های گردش کار به منظور ایجاد سیستم تجارت الکترونیک

۷) تعیین نمودار جریان های عمومی سیستم تجارت الکترونیک سازمان در لایه زمینه (سطح صفر)

۸) با توجه به فهرست جریان های ورودی و خروجی بدست آمده در سئوال قبلی، نمودار پیمایش واسط های کاربر برای نرم افزار سیستم تجارت الکترونیک بنگاه مورد نظر را طراحی نمائید.(توجه: در صورت نیاز می توانید به مجموعه عناوین حاصل، موارد دیگری را حسب نیاز و جهت تکمیل نمودار پیمایش اضافه نمائید.)

بخش (ج): با توجه موارد ارائه شده در بخش قبل و سمینارهای ارائه شده در کلاس و همچنین جوابهای حاصل از پاسخ به سئوالات این بخش، به سئوالات زیر پاسخ دهید:

۱) مطالب و محتوای کدامیک از مقالات ارائه شده در سمینارهای کلاسی، در راستای ایجاد کدام بخش از سیستم تجارت الکترونیکی برای کتابفروشی قابل استفاده و بکارگیری است؟ کاربرد هر یک را در حد اختصار بیان نمایید.

۲) جزئیات نحوه استفاده از دو مورد از روشها و ایدههای مطرح شده در مقالات ارائه شده در سمینارهای کلاسی را به اختیار توضیح دهید. در این رابطه فرض کنید که سیستم تجارت الکترونیک کتابفروشی، به عنوان مثال عملی مقالههای انتخاب شده، در نظر گرفته می شوند.

(موفق باشید)

خیلی وقت ها در داده کاوی مجبوریم Data Alaysis انجام دهیم

فرق Data Analysis با Datamining این است که در تحلیل داده ها فرضیه ای را مطرح می کنیم و در مورد صحت و سقم آن نظر می دهیم

ولی در داده کاوی سوال هنوز مطرح نشده

می بینیم چه سوال میشه از دل این داده ها در آورد

یکی از تکنیک ها کمتر شنیدیم جداول توافقی یا جداول پیشایندی هستند

clementine قوی ترین نرم افزار در جداول پیشایندیContigency Table هست

برای جدول یک بعدی و دو بعدی یک مدل بیشتر برازش نمیشود

اساس جداول پیشاوندی DataAlanysis هست

چون به این سوال می خواهیم جواب دهیم که

داده ها را به دو قسمت تقسیم بندی می کنیم

(کمی – کیفی)

داده های کمی به دو دسته ( پیوسته – گسسته ) تقسیم بندی می کنیم

داده های ترتیبی هم می تواند باشد

فرض هایی که در مورد داده های کیفی هست :

۱-در مورد درصد نظر می دهیم (درصد اقایان بیشتر است یا خانم ها )

۲- یا در مورد استقلال ، مثل (سیگار به سرطان ربط دارد ؟ )

Z test

chi square

سرطان – سیگار – جنسیت )- تعداد مدل ها خیلی زیاد می شود

مثلا درصد آرای ۵ کاندیدایی که در انتخابات شرکت می کنند

خطای غیر نمونه گیری و خطای نمونه گیری داریم

فر می کنیم ازمایش Multinomial داریم که حالت توسعه یافته برنولی هست

آزمایش های مولتی نومیال مانند باینومیال مستقل از هم و درصد احتمال هم یکی است

( اگر از یک نفر بپرسند که به کدام یک از این ۳ نفر رای می دهی احتمال انتخاب با نفر بعدی که پرسش می شود یکی است )

آزمایش مولتی نومیال n نفر را به تصادف انتخاب می کنیم

هر یک نفر که انتخاب شده اند به یکی از این k کاندیدا رای می دهند

شرط اول : اگر نفراول احتمال انتخاب p بود نفر بعدی هم احتمال p باشد

شرط دوم : رای نفرات از هم مستقل باشد

N=100

k=3

p=1/3

در جدول پیشایندی نمایش می دهیم ( جدول توافقی )

سوال: ایا ارای این سه نفر یکی است ؟

درآمار شاید ۳۵ با ۴۵ برابر باشد چون ممکن است خطای نمونه گیری داشته باشیم

بنابراین باید آزمون انجام بدهیم

chi Square Test

به دنبال یک استراتژی منطقی برای Treshould که بتوانیم مقایسه کنیم

چون می شود ثابت کرد که این treshold

آمار آزمون همون استراتژی منطقیمون هست

آمار آزمون میاد تعداد مشاهدات را در مورد p1 انجام شده است n1 Observed Value منهای exepected Value

مقایسه را زمانی انجام می دهیم که فرض H0 درست باشد

استقلال را جدول دو بعدی می گوییم

با داده های کیفی در مورد استقلال صحبت می کنیم

در تست استقلال برای جداول دوبعدی مطرح می کنیم

مانند شرایط قبل آیا ارتباطی بین

فرض ها Mulinomial experient هست

فرض H0 آیا نوع خانه و مکان ساخته شده آیا با هم وابسته هستند و یا مستقلند

اگر وابسته نباشند درصد خانه ها چقدر است ؟

expected =حاصلضرب …. تقسیم بر تعداد کل

جدول توافقی دو بعدی

اگر قرار باشه مکان و نوع ربطی به هم نداشته باشند

۱۱۲/۱۶۰ تابع چکالی کناری Marginal

باید تابع چگالی توام مساوی

از نظر شهودی اگر آزمایش انجام دادیم که با آزمایش دیگری از نظر فیزیکی ربطی به هم نداشت از نظر ریاضی هم مستقل هستند

احتمال joint را چجوری حساب می کنیم ؟

احتمال ۶۳ مشیه حاصلضرب این دو احتمال

و وقتی می خواهیم Expected را انجام دهیم ….

در این جلسه در باره جدول توافقی وجدول chi square

صحبت شد

سه فصل امتحان می گیریم

– فصل ۱ و ۲ کتاب Tan به صورت تستی

– خوشه بندی از جزوه انگلیسی و به عنوان کمکی جزوه فارسی می توانید استفاده کنید

– Asociation Role ها

بارم نمرات : ۶ تا ۸ نمره پروژه و ۱۲ تا ۱۴ نمره امتحان دارد

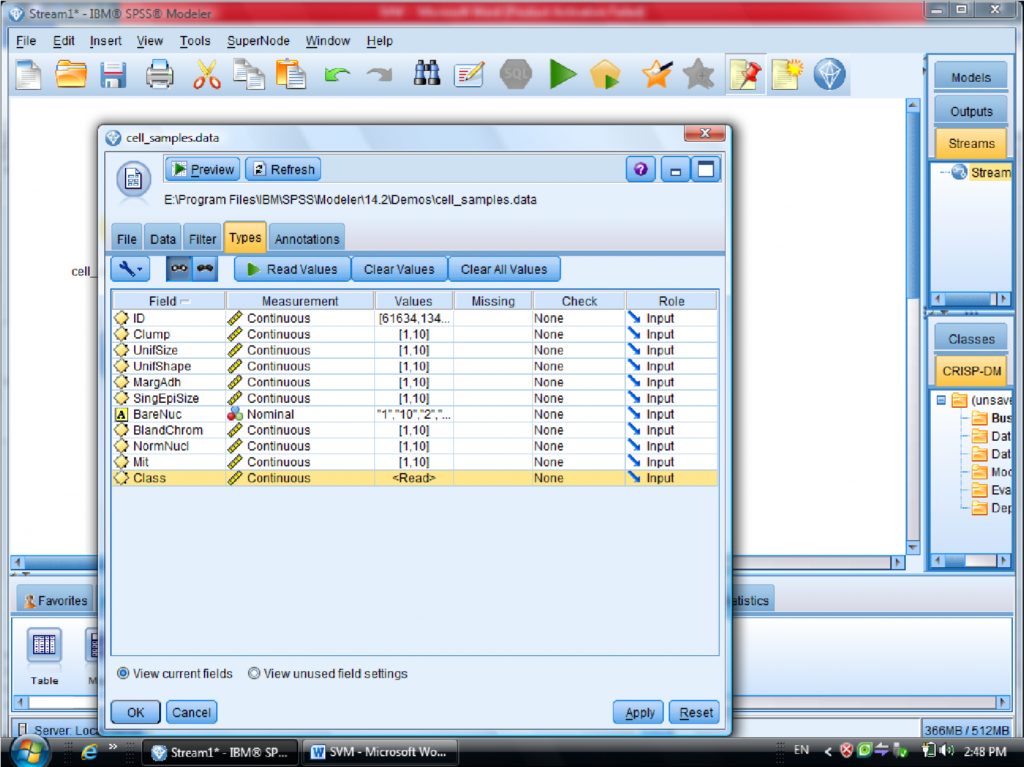

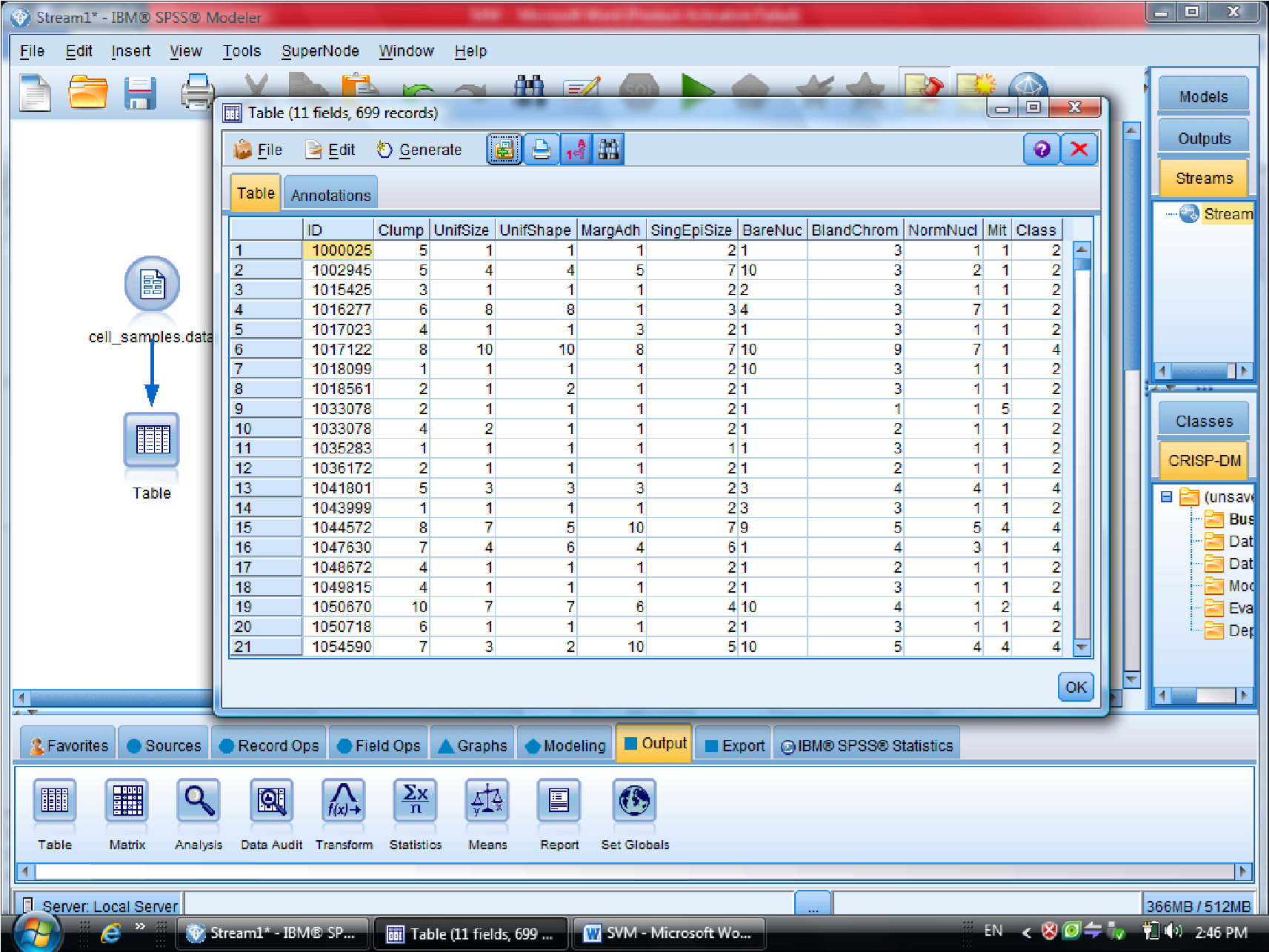

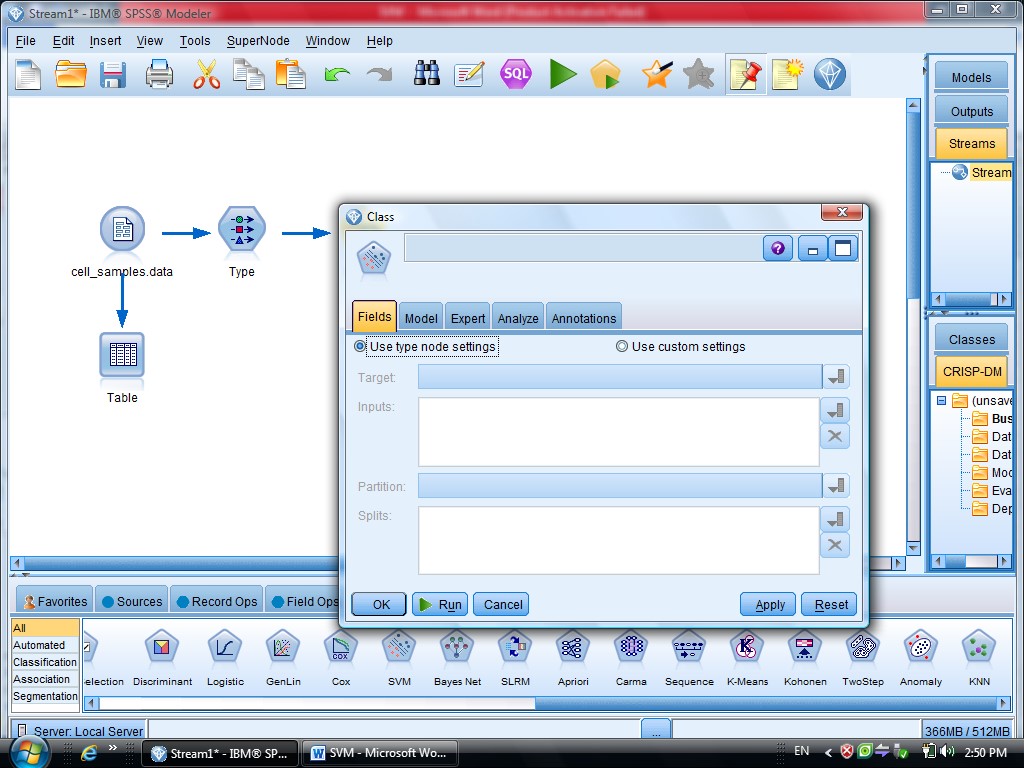

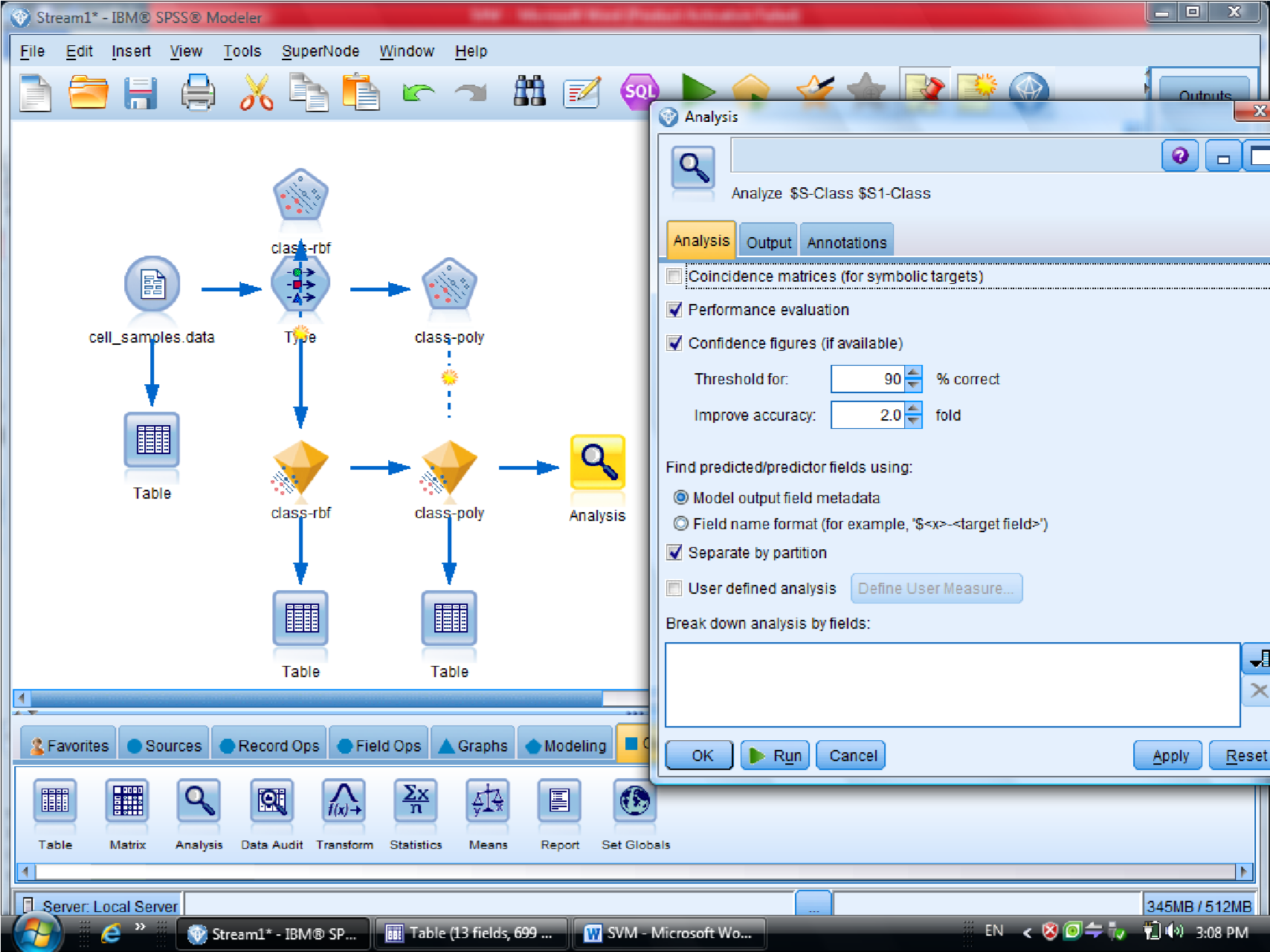

الگوریتم SVM در Clementine

SVM معمولا برای داده های بزرگ به کار می رود

SVM – Support Vector Machine از خانواده یادگیری ماشین و هوش مصنوعی هست

معمولا زمانی از این روش استفاده می کنیم که حجم داده ها خیلی زیاد باشد

مثلا راجع به داده های پزشکی ، سلولهای سرطانی کاربرد دارد

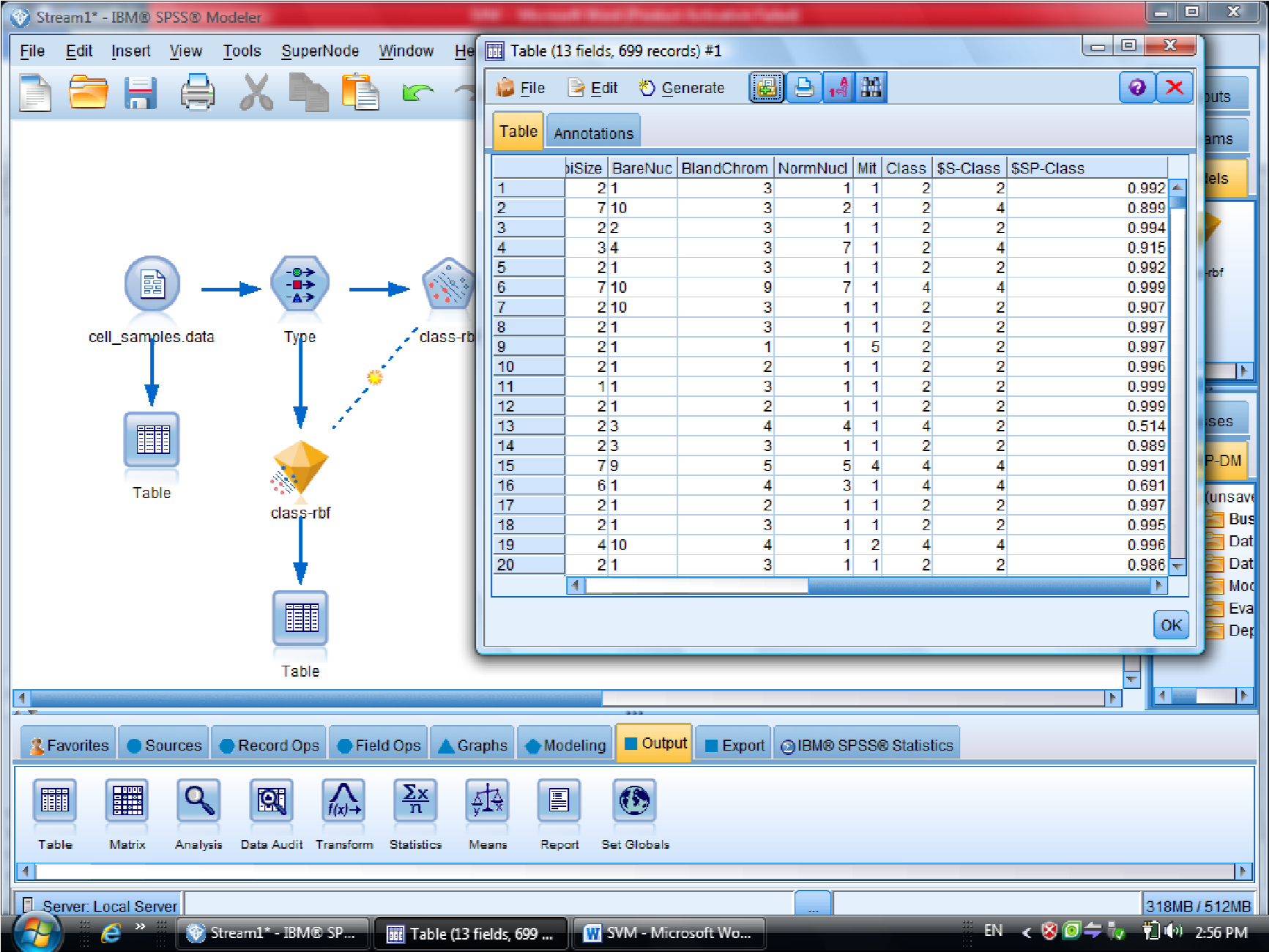

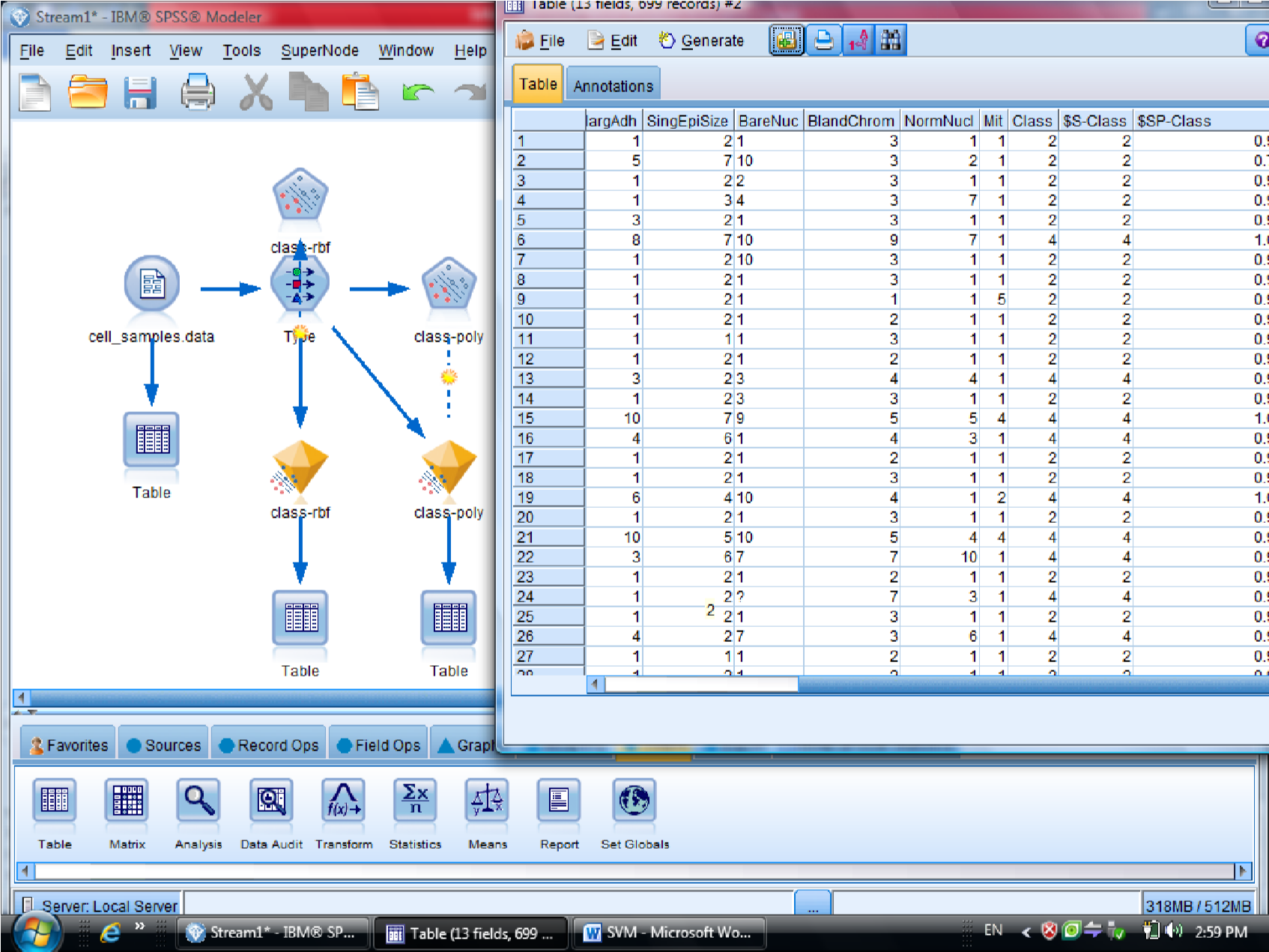

در اینجا مثالی که در Clementine هست کار می کنیم به نام Cell_samples

در این مثال متغیر Clump مشخص کننده سرطانی بودن سلول هست

متغیر ها به عنوان اندازه، شکل ، رنگ , آورده شده است و متغیر های دیگر همچنین فیلد خوش

خیم بودن سلول یا بدخیم بودن آن

که برای سلول های خوش خیم و بدخیم اطلاعات را دسته بندی می کنیم

برای این کار داده های آماده در کلمنتاین به نام Cell Samples Data که از نوع fixfile است ، می

آوریم

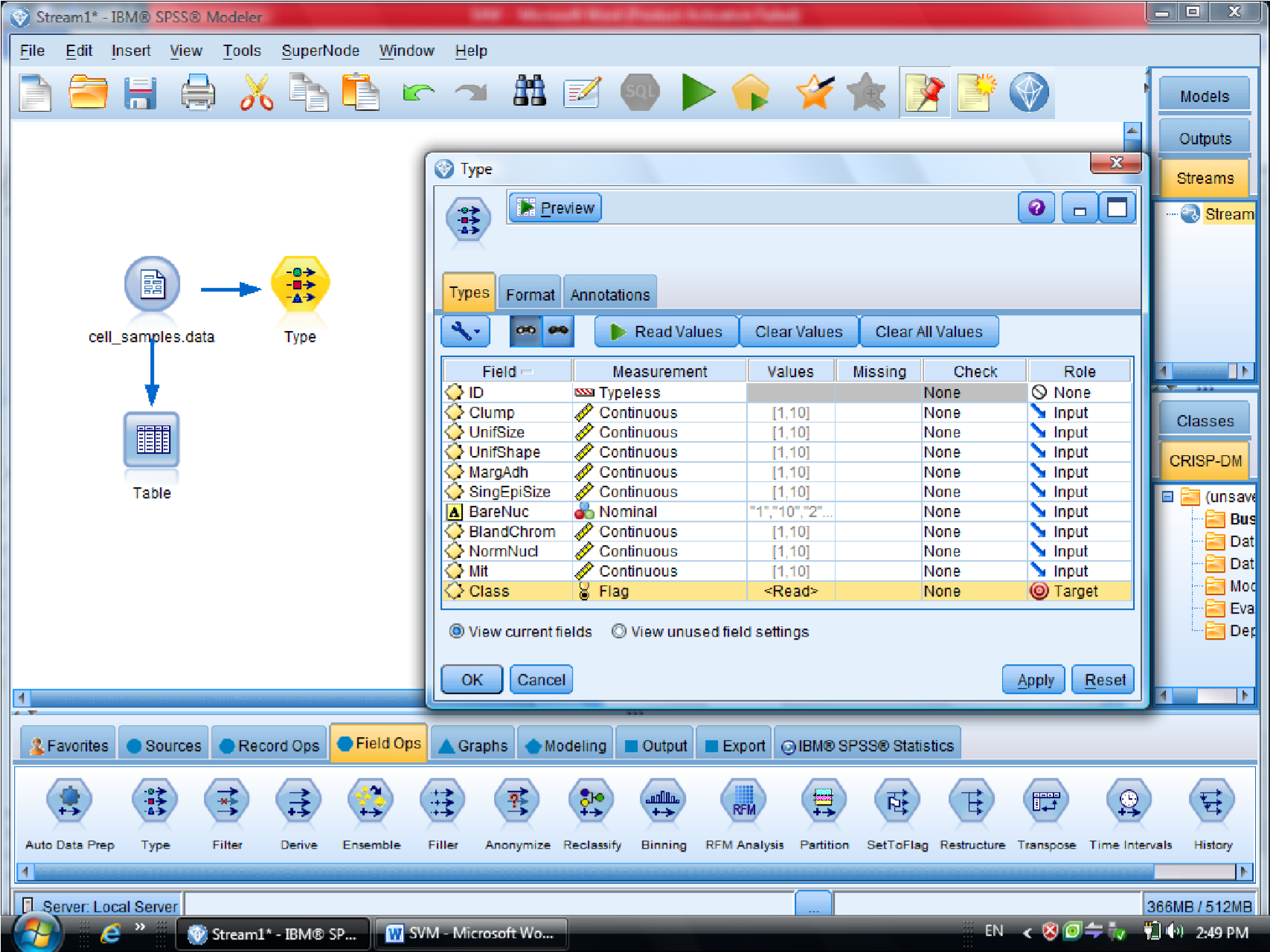

در این دیتا ست ، فیلد ID چون جزو متغیر های موثر نیست آن را فیلتر می کنیم (ID رو Typeless

کردیم)

متغیر class را به عنوان Target معرفی می کنیم (فیلدی که خوش خیم بودن سلول را مشخص می

کند )

بعد از Type مدل SVM را قرار می دهیم

در گزینه type – SVM – Field متغیر های مستقل هستند ، همه متغیر های دیگر دخیل هستند

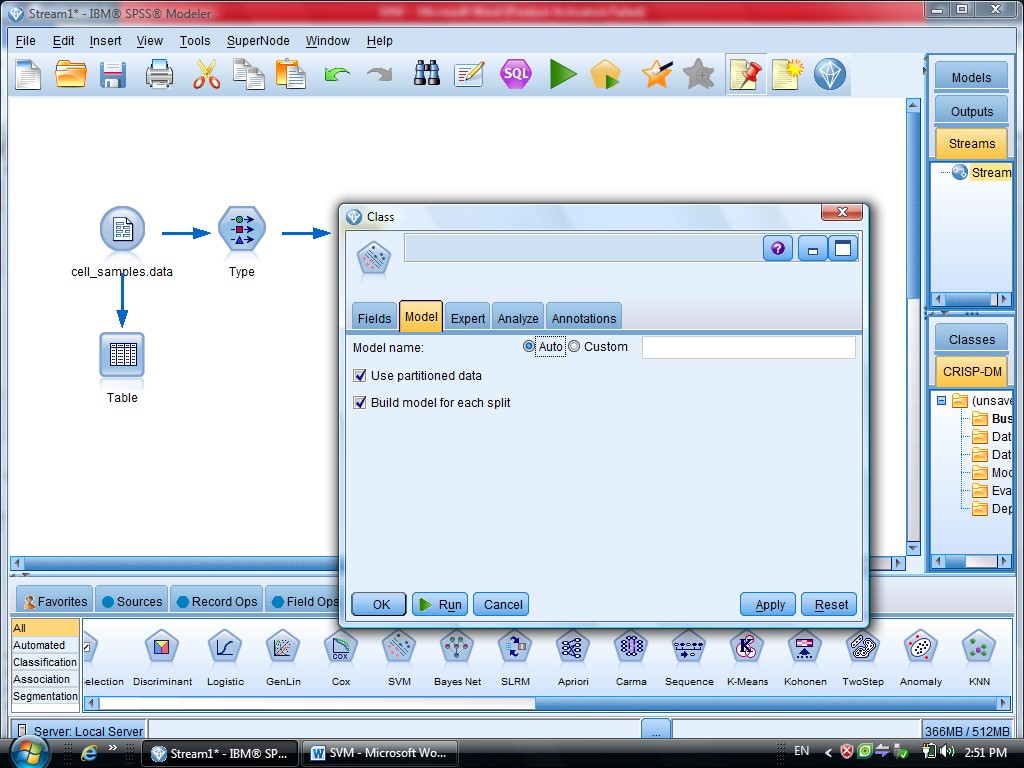

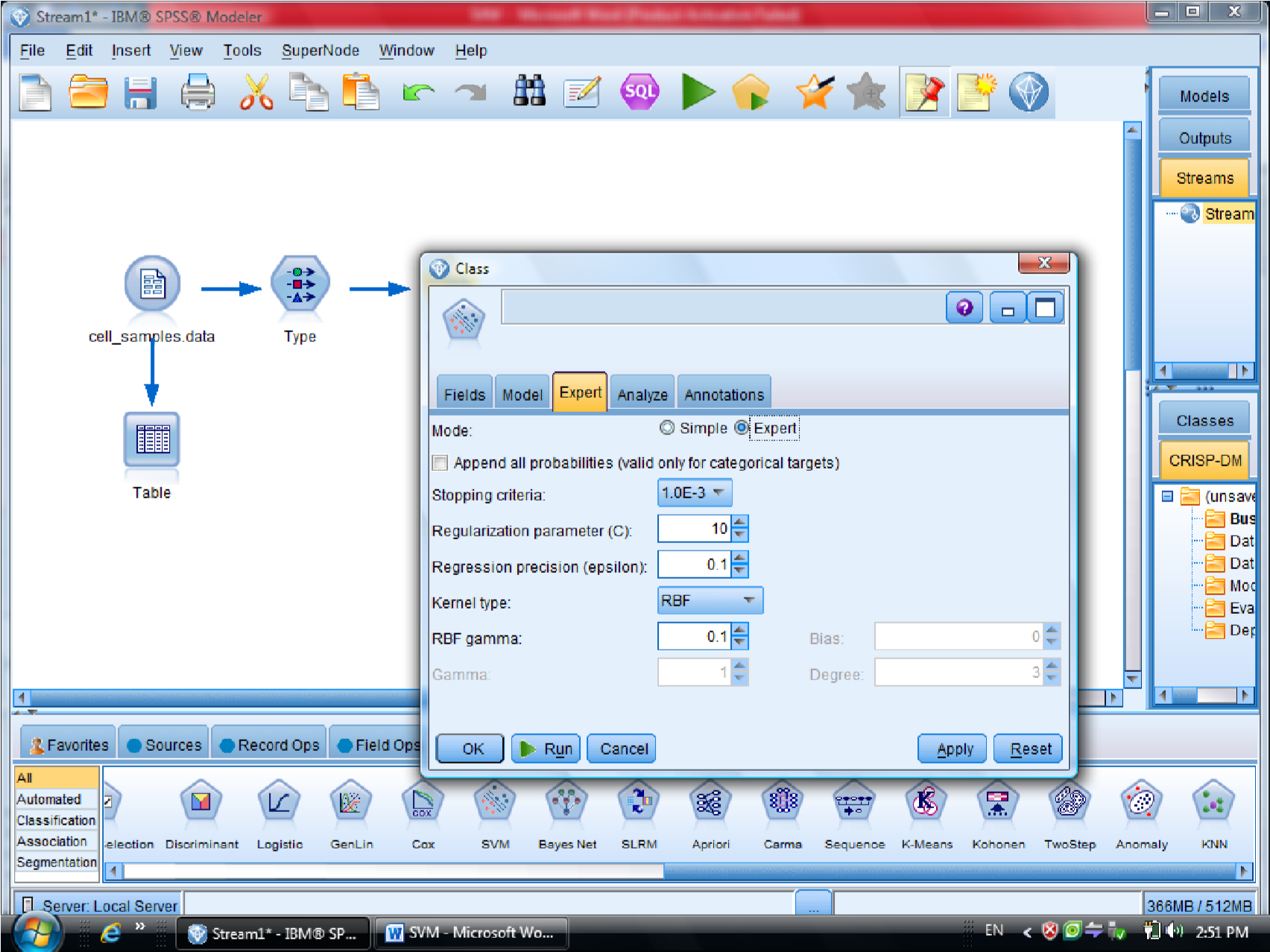

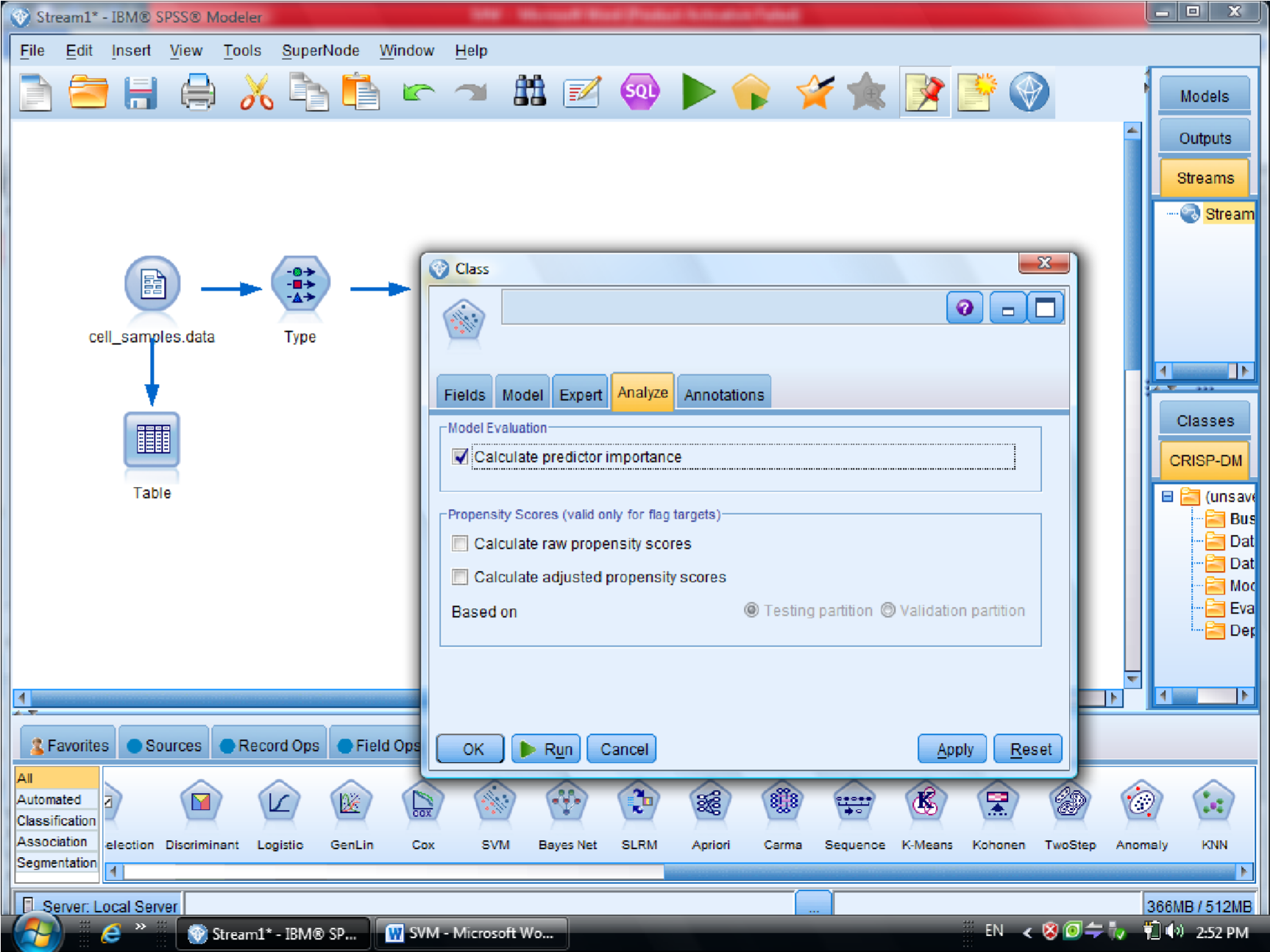

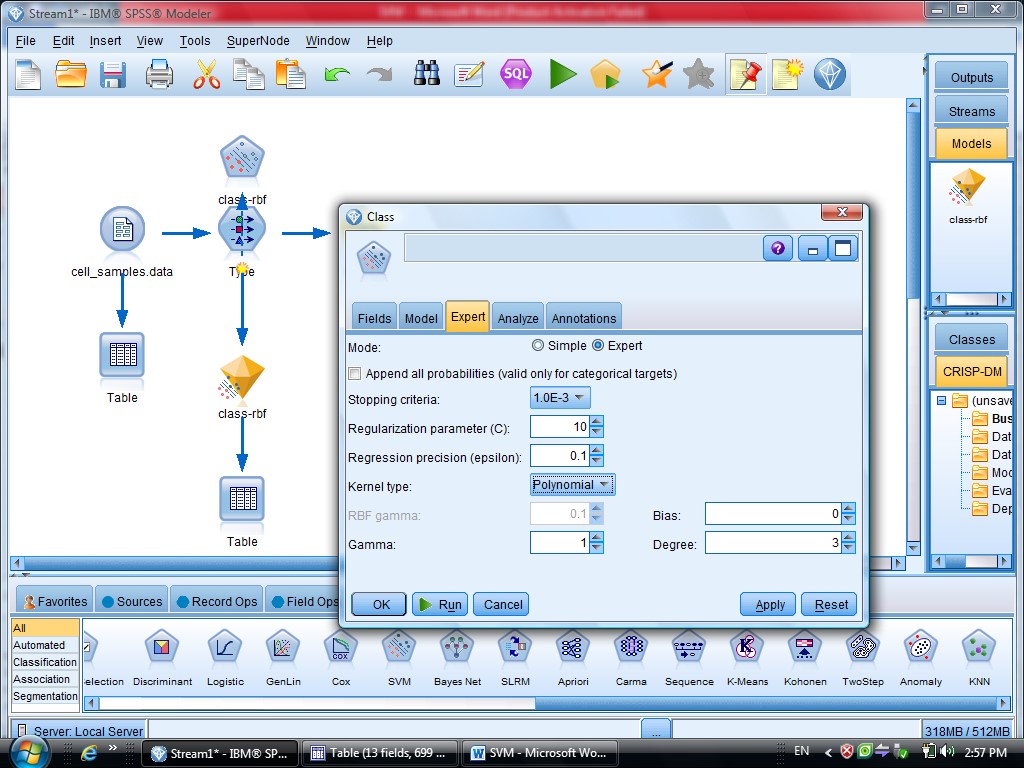

گزینه Expert در متد SVM دو گزینه sample , Expert را داریم

که ما از گزینه Expert استفاده می کنیم برای اینکه بتوانیم چند روش برای دسته بندی داده

استفاده کنیم

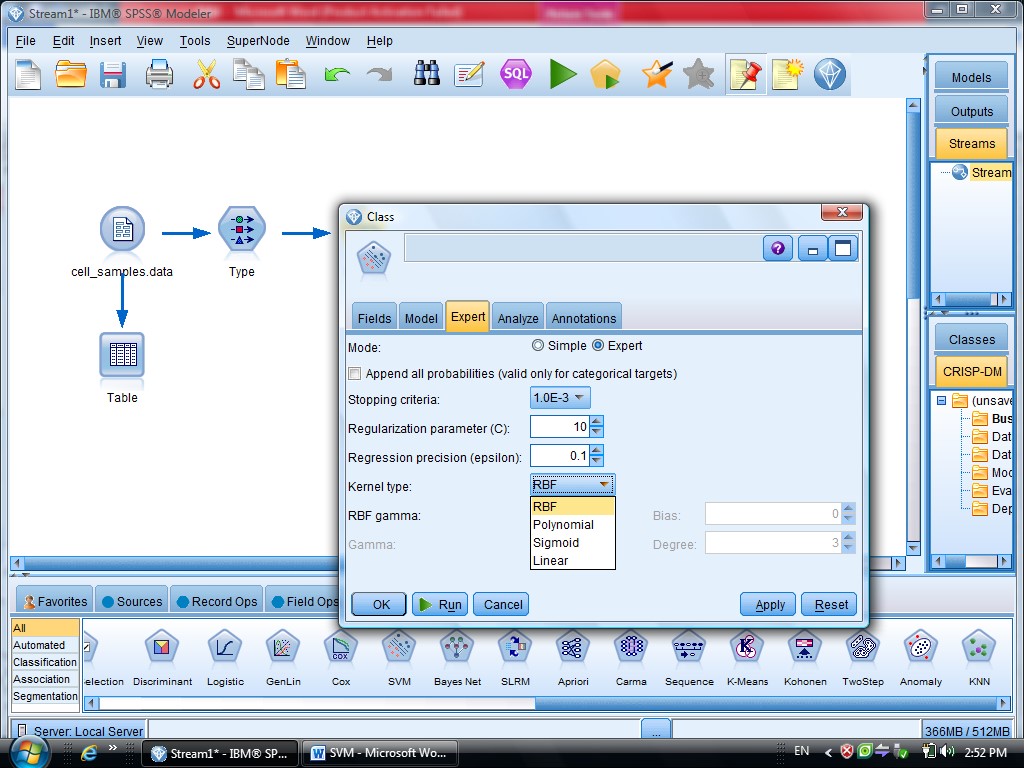

در SVM از تابع Kernel استفاده می شود

درجه وابستگی متغیر ها را می توانیم با SVM مشخص کنیم

گزینه Model مربوط به مدل آیا دیتا های ما از چند قسمت تشکیل شده اند یا خیر

کرکره Expert دو گزینه دارد (Simple , Expert)

یاد آوری می شود روش های SVM از تابع کرنل هست

ممکنه روشهای مختلفی استفاده کنیم

با انتخاب گزینه Expert می توانید از توابع Kernel استفاده کنیم

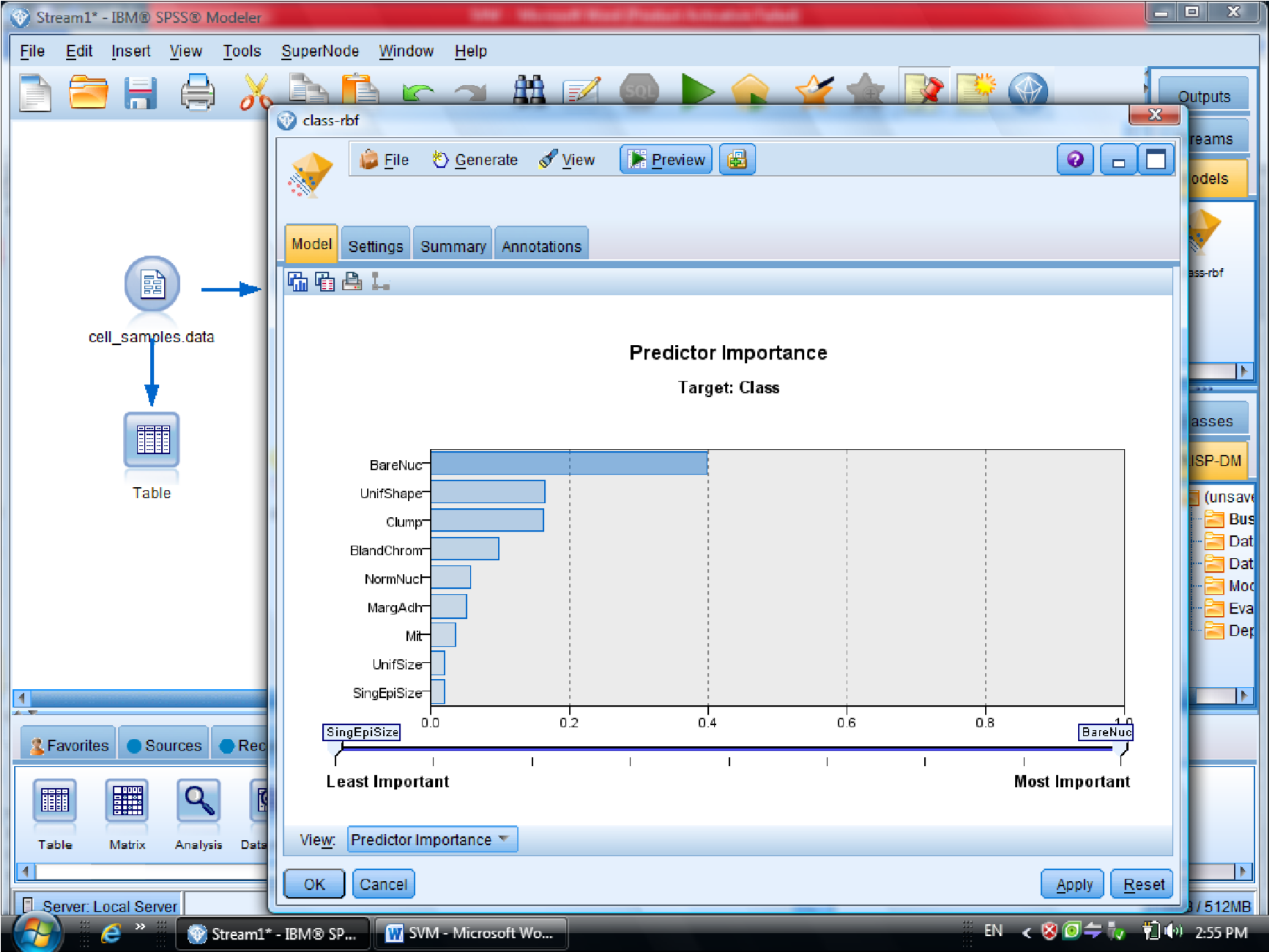

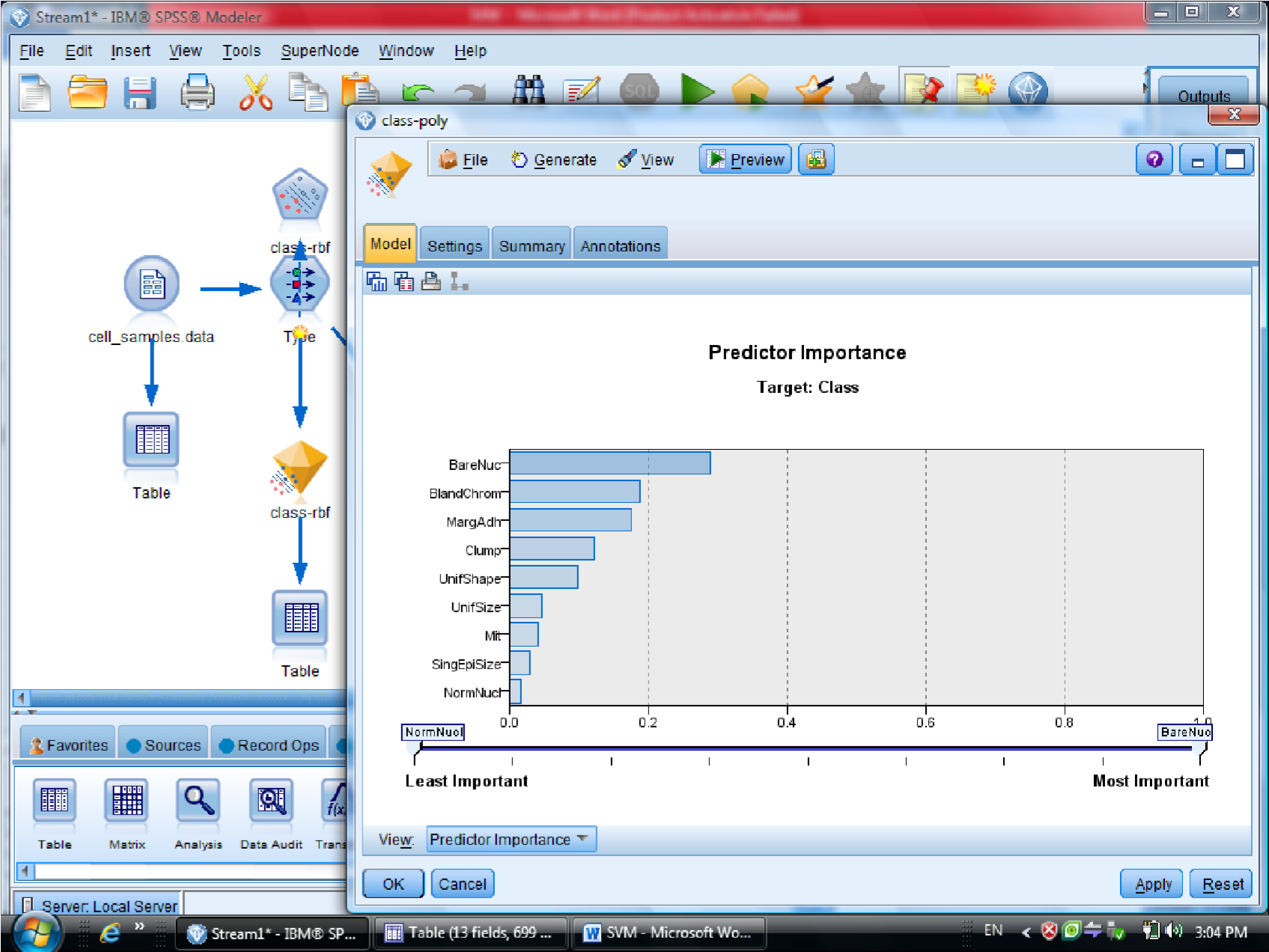

در قسمت اول متغیر ها را بر اساس درجه اهمیت نشان می دهد

احتمال برای درست پیش بینی شدن را می دهد

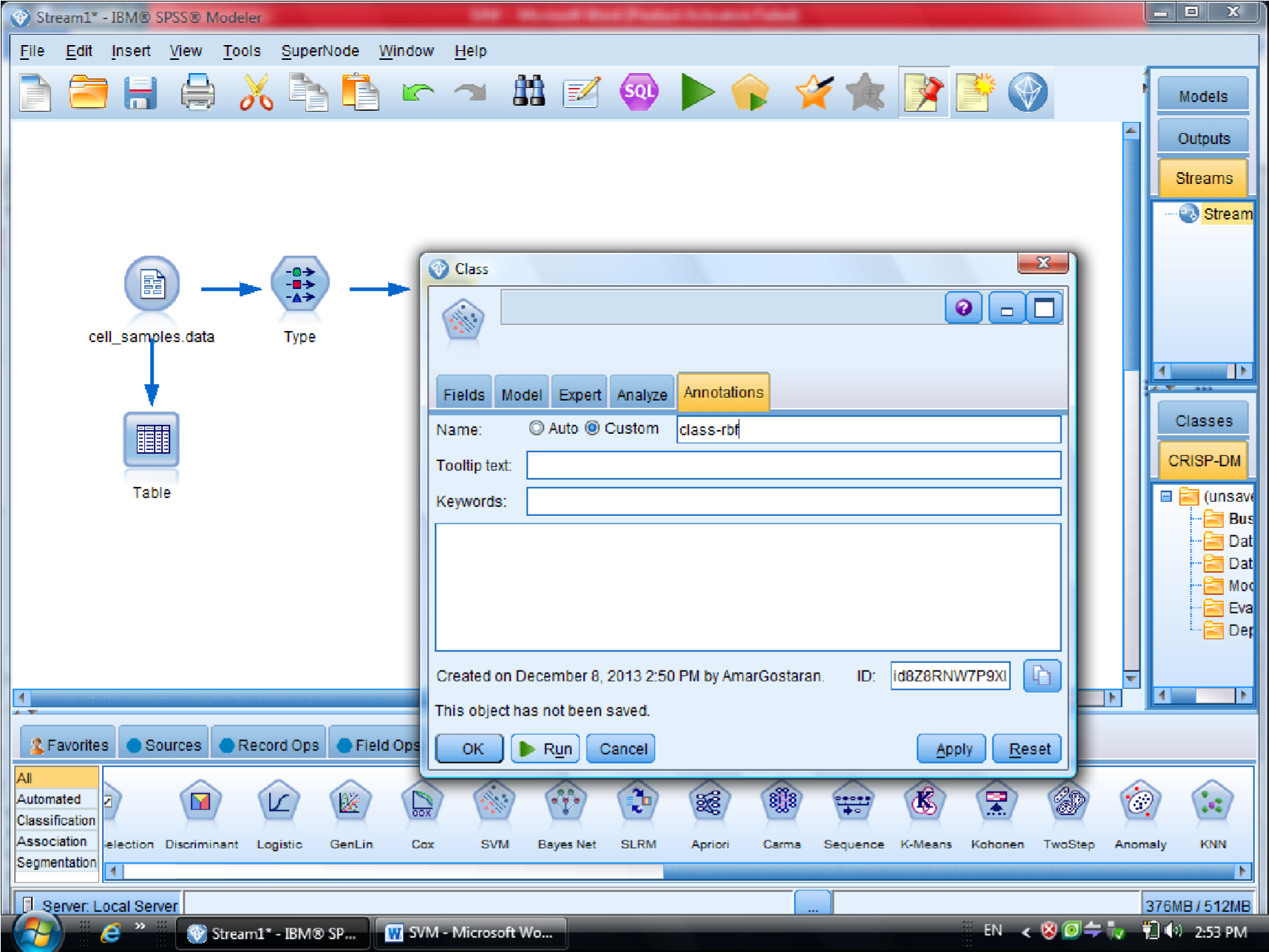

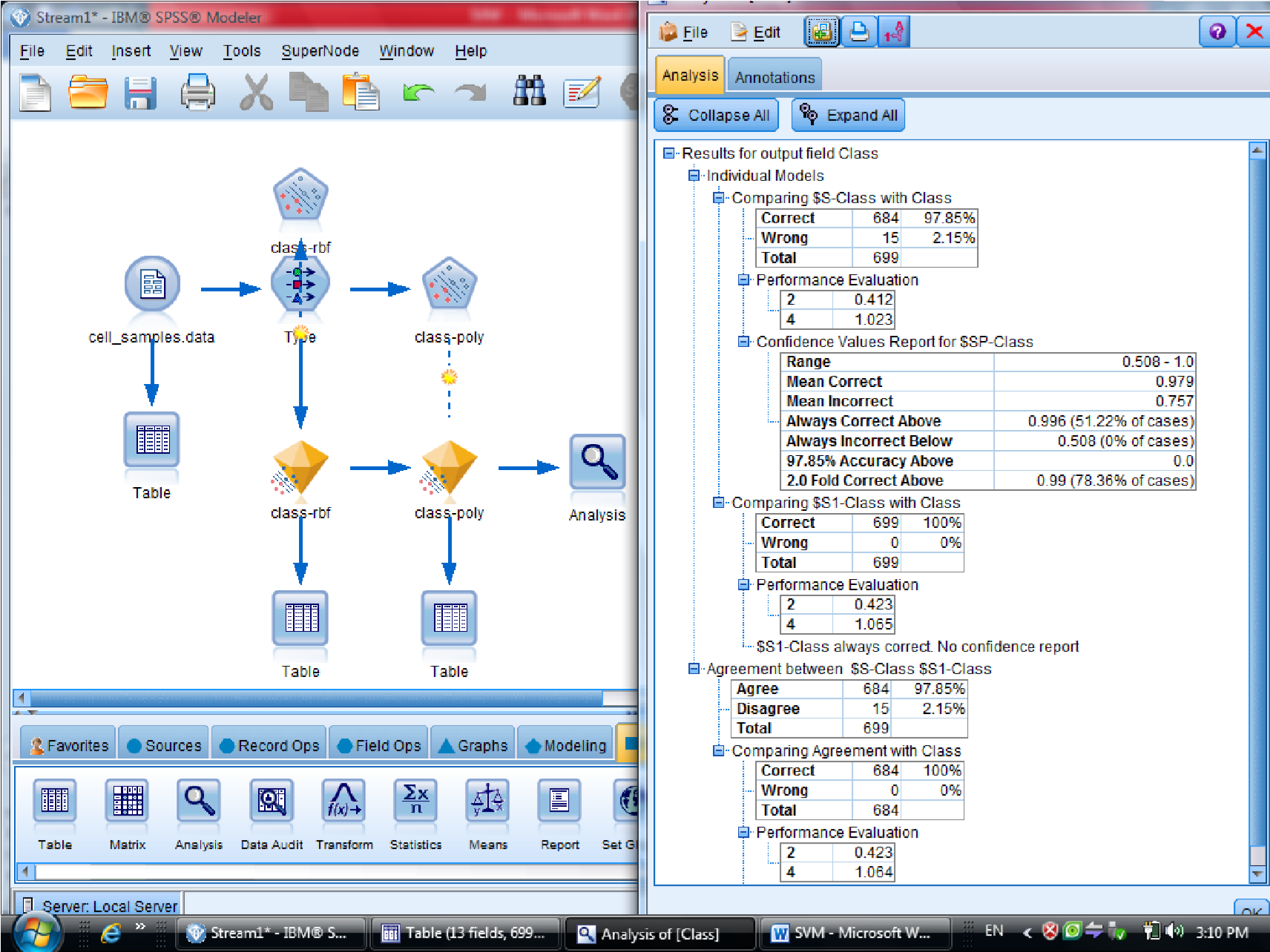

یکبار به روش RBF خروجی گرفتیم

این مقدار احتمال ها ممکن است خیلی به ۱ نزدیک باشد

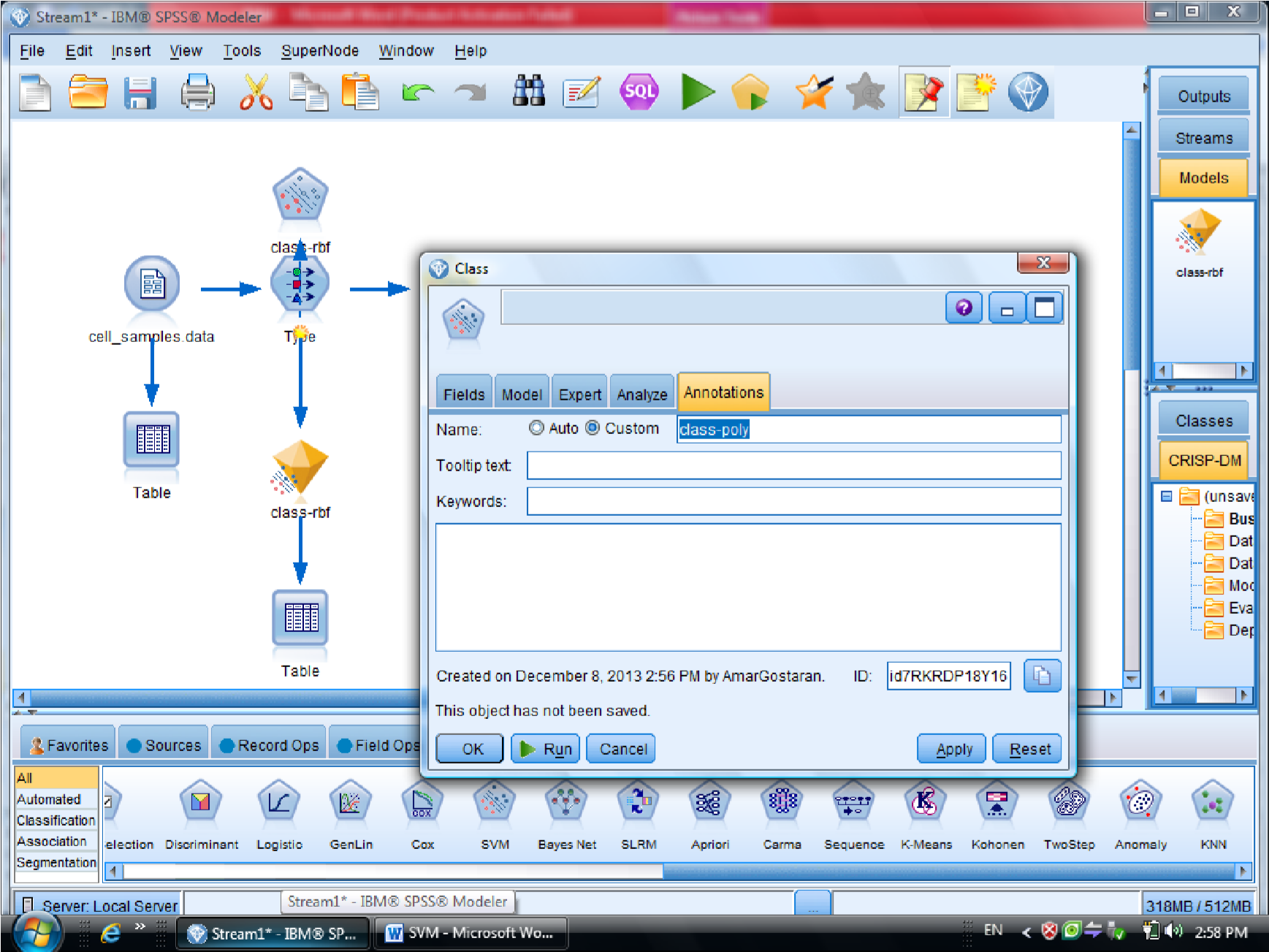

به روش Polynomial (چند جمله ای )، خروجی مربوطه برای متغیر هایی که این فرم را دارند

میزان دقت polynomial صد در صد هست

برای مقایسه دو نتیجه دو تا الماس زرد را با هم مرتبط می کنیم ( با F2 )

و به Analysis وصل می کنیم تا مقایسه این دو نود را ببینیم

در نهایت متدی که به ۱۰۰ نزدیک تر هست ، روش مناسب تری هست

درصد دیتاهایی که درست تشخصی داده را ۰٫۹۷۹ هست

سلول های سرطانی خوشخیم که با ۲ علامت گذاری شده هست ، با احتمال اشتباه بیشتری

هست

در روش دوم ( polynomial ) میزان دقت سلول سرطانی ۱۰۰% هست

ولی برای سلول های سرطانی خوشخیم درجه احتمال بیشتری را خواهد داشت

پس بین این دو روش polynomial بهتر است

این مثال در فصل هشتم داده کاوی و کشف دانش گام به گام با Clementine خانم علیزاده هست

fine

داده کاوی و کشف دانش گام ب گام با نرم افزار Clementine علیزاده د.خواجه نصیر

یکی از روشهای مورد استفاده از متد های شبکه عصبی در داده کاوی هست

مثلا رگرسیون ارتباط متغیر های وابسته به متغیر های مستقل نشان می دهد

مثلا شرکت ها چقدر بدهی داشته باشند

سوالات :

سوال اول تعریفی است

مثلا desicion Tree

الگوریتم هایی که استفاده می کنید

درجه اطمینان و میزان پشتیبانی

روشهای خوشه بندی – kmeans خوشه بندی کنید

با Complete Linckage یا Average Linkage

آزمون تمام مطالب سر کلاس هست

Continue reading »

Continue reading »

نوشته های تدریس یار درس خوشه بندی استاد حمیدرضا برادران کاشانی

دوستان عزیز لطفا همه توجه کنند و هیچ کامنتی نگذارند

۴ نوع تمرین است

هر کسی بایستی تمرین گروه خود را بصورت مستقل انجام دهد.

یعنی هرگز کار گروهی نیست

گروه ها را بصورت رندوم انتخاب کرده ایم.

تمرین در هر گروه بر اساس بهترین تمرین در آن گروه و بصورت نسبی ارزیابی می شود.

دوستان امروز صدا نداریم.

بنابراین گروه آسان یا سخت نداریم. یا تمرین آسان و سخت

اهمیت این تمرین که در واقع بصورت یک مینی پروژه است از سایر تمرین ها بیشتر بوده

بنابراین دوستانی که در تمرین های گذشته کارشان به نظرشان اشکالات یا کاستی های داشته می توانند در این مینی پروژه جبران نمایند.

باز هم تاکید می کنم که بهترین فردی که در هر گروه بهترین و کاملترین گزارش در آن

گروه را ارائه دهد معیاز ارزیابی آن گروه می باشد.

ضمنا تمرین فیشر را نیازی نیست کسی نجام دهد

این تمرین را به عنوان آخرین تمرین درس در نظر گرفته ایم.

لطفا تمرین را دانلود کنید همه چیز اعلام شده

پیاده سازی نمی خواهد فقط گزارش کامل

روش هایی که هدفشان تمایز بین داده های دو یا چند کلاس است مثل فیشر دیگر چه روش هایی داریم

در مورد تمرین سوالی نیست؟

روش VQ

, Kmeans

چه روش های مشابهی وجود دارند

در تمامی گروه ها هدف بیان توابع cost function جدید است

اسم تمرین در سایت shw2 است

دوستان اگر با تمرین کمی کار کنند

بعد می توانند سوالاتشات را از طریق ایمیل clustering_1391 – yahoo بپرسند

کلاس حضوری داده کاوی – ۹۲/۰۹/۲۱

آقای مهندس حائری – مرکز افکار سنجی جهاد دانشگاهی

دموی تمام الگوریتم ها را ببینید

در داده کاوی ممکن است یکی از کار های بخواهیم

توصیف

مقایسه کردن ( با استفاده از الگوریتم های t , z , Anova , Manova امکان پذیر است )

بررسی رابطه (ضریب همبستگی یا ضرایب پیوند – انواع رگرسیون )

رده بندی و خوشه بندی (درخت تصمیم – درخت رگرسیونی)

پیش بینی (time series)

پروژه ها را شروع کنید

تا آخر بهمن احتمالا وقت هست برای تحویل پروژه

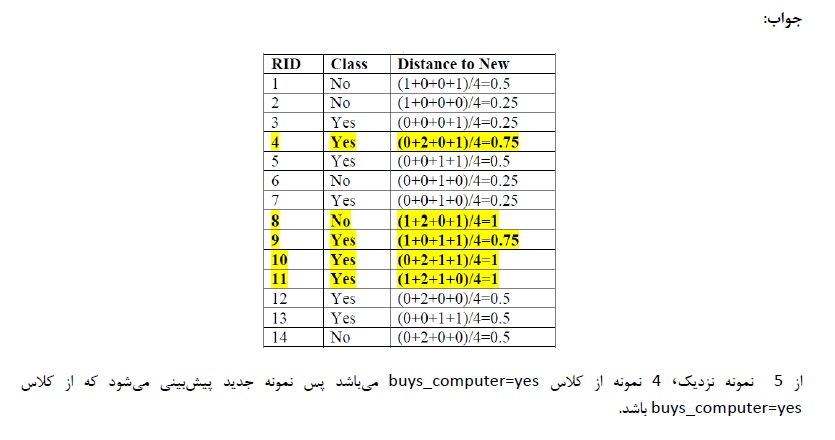

جواب نمونه سوالات ترم گذشته

سوال ۱ :

a) درست است

b) نادرست است (تحلیل مولفه های اصلی نیست – اصلا به تعداد کلاسها توجهی ندارد )

c) نادرست ( EM در GMM بود و در سلسه مراتبی نیست )

d) درست است

e) درست است

f) اشتباه است

سوال ۲ :

a) در PCA مولفه های موثر در را مشخص می کند

b ) فیشر – خطی بودن

c) رسم نقاط – با روش فیشر حل می کنیم

SW^1(mu1-mu2)

سوال ۳ :

a) برچسب داشته باشد بهتر است

b) تعداد داده های اشتباه تقسیم بر تعداد کل مشاهدات

برای بهتر شدن و جلوگیری از Overfitting از CrossValidation میشه استفاده کرد

c) هزینه محاسباتی زیاد است – برای کاهش بعد

ابتدا باید similarity را باید حساب کنیم ( بجای محاسبه distance )

نمونه جدید را داریم

نونه سوال ترم پیش : نمونه سوال خوشه بندی – دکتر زارع

————-

ارائه خانم مهندس شیخیان

روش خوشه بندی Cure

یک روش خوشه بندی سلسله مراتبی است

سلسله مراتبی ها

خوشه ها از بالا به پایین خوشه ها مشخص تر هستند ولی انباشتگیشون بیشتر است

تمرکز خوشه بندی یک نقطه هست و بر اساس میانگین خوشه ها می تواند با هم merge شوند

مزیت Cure نسبت به سایر روشهای سلسله مراتبی تشخیص خوشه های کروی و غیر کروی را می تواند

انجام دهد

مزایای Cure حساس نبودن به شکل هست

وبه Outlier حساس نیستند چون خوشه بندی را بر اساس میانگین انجام می دهند و نه بر اساس فاصه

نقطه ها

یک الفا بین صف و یک تعریف می شود

و هر چه به صفر نزدیک تر باشد بر اساس تمام نقاط ورودی

و هر چه به یک نزدیک شود بر اساس یک نقطه انجام می دهد

در هر خوشه که تعدای نقاط را داریم

بر اساس Merge شدن نقاط هست

بقیه نقاط در مراحل بعدی با هم Merge می شوند

این روش ار random Sample استفاده می کند

خوشه بندی در دو مرحله صورت می گیرد

دیتا های ورودی پارتشین می شود

خوشه بندی ناقص انجام می شود

outlier های حذف می شود

خیلی مهم است که اندازه random Sample درست محاسبه شود.

چون ممکن است حجم محاسبات زیاد شود و یا اینکه خیلی داده ها دیده نشوند

شرط خاتمه این الگوریتم نسبت n به q هست

در سرعت این الگوریتم (Sample size و تعداد Partition ها ) بسیار مهم است

مهمترین خاصیت »: خوشه های غیر کروی هم می تواند انجام دهد

قابلیت محاسبه big data دارد

استفاده از Partitioning

———————————————————

ارائه خانم مهندس قربانی

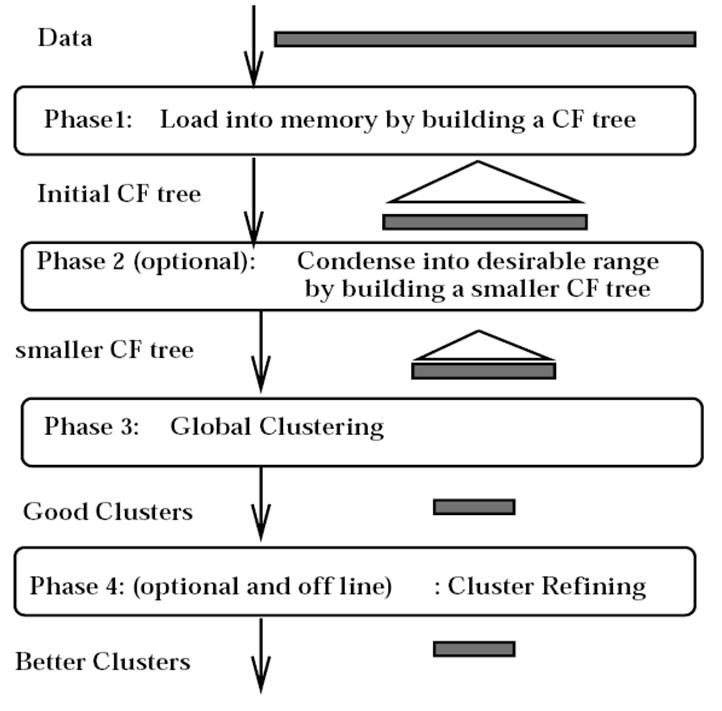

الگوریتم Birch

برای Big Data – استفاده از الگوریتم های ساده امکان پذیر نیست

قبلا بر اساس احتمال ( یادگیری ماشین ) و یا بر اساس آمار ( روش های فاصله ) کار می کنند.

در روشهای اماری هزینه IO خیلی زیاد است

ولی روش Birch مشکلات روش های قدیم را ندارد

تراکم خوشه ها حول جرم را نشان می دهد

اگر دو خوشه را در نظر بگیریم ۵ تا معیار داریم

با استفاده از این ها فاصله اقلیدسی یا فاصله منهتن را محاسبه کنیم

با استفاده از فرمول به فاصله خوشه ها می رسیم

یک درخت به نام CF Tree می سازد

تا بتواند خوشه ها را با هم ادغام کند

در مثال آخر LS و SS مشخص شده اند

LS : مجموع خطی داده ها ست

SS : جمع مربعات n داده هست

هر کدام از پارامتر ها یک ارتفاعی دارند

که درخت CF انها را بالانس می کند

بردار CF ذخیره می شود و داده ها ذخیر نمی شود

و با کم کردن اطلاعات داده ها از هزینه های جابجایی جلوگیری می کند

منبع : کتاب Mining of Massive Dataset

ایده کلی : تفاوت مهم Random Sampling بود

ولی birch نقاط را تبدیل به Future می کرد

دانلود رکورد کلاس حضوری دکتر محمد پور

خلاصه جلسه داده کاوی – حضوری – دکتر محمد پور

کاری که PCA انجام می دهد تعداد متغیر ها را کم می کند

ایراد های عمده PCA :

۱- مفهوم متغیر ها را عوض می کند

( ماتریس واریانی – کواریانس )

ماتریس واریانس را حساب می کنیم با ترانهاده اش ماتریس واحد شود

اگر بردار وِیژه را بدست بیاوریم ماتریس متعامد را بدست می آوریم

نتیجه : متغیر ها وابستگی به هم ندارند

بدی PCA داده های برست آمده ترکیب شده هستند

درPCA های مختلف مقایسه کار سختی است

دومین اشکال PCA : باید بردار ویژه و مقدار ویژه را پیدا کنیم

بعضی مواقع متغیر ها بسیار زیاد است محاسبه بردار وِیژه و مقدار ویژه کار بسیار سختی می شود

اشکال سوم PCA : داده ها

Uncorrolocated می شود

رابطه خطی با هم ندارند

مزیتهای PCA :

۱- بر اساس واریانس عمل می کند

به اندازه مقدار ویژه به خودش اختصاص می دهد

———————–

برای کلاسترینگ هیچ وقت از PCA استفاده نمی کنیم – فقط برای کاهش بعد استفاده می کنیم

——————————

روش Random Projection :

مزیتها :

۱- هزینه محاسباتی ناچیز است

۲- فاصه نقاط را حفظ می کند

آیا می توانید روشی را ارائه دهید که هم بعد را کم کند و دقت کاهش پیدا نکند

Stable Random Projection پایان نامه دکتر زارع

هر توزیعی یک نرمی را حفظ می کند

در روش های آماری جایی باشد که دیگر دقت کم نشود

تغییر ظرح نمونه گیری می گوییم

بعضی وقتها حجم نمونه

نحوه نمونه افراد را تغییر دهیم

واریانس این بر آورد گر نصف قبلی می شود

روش مکنتایر – در استرالی بر آورد محصول گندم را بدست آورد

در مساله کلاسترینگ یک نوع مثال بیاورید که داده ها را بعدش را کم کنیم و دقت کاهش نیابد

Ranked Set Sampling

———————

سوالات امتحان :

– Association Analysis

Clustering فارسی با فصل ۱۴ کتاب سلسه مراتبی تقریبا یکی است

DataMining-Tan-SolutionManual.pdf – سوال ۵ نمی آید

———————-

ICA

BSS :

سه نفر به سه میکروفن حرف بزنند ، صحبت ها قاطی می شود

Blind Source Seperation

جدا سازی منابع کورکورانه

مثلا یک سیگنال داریم که سیگنال اصلی را نداریم

چطور با استفاده از X بتوانیم S را بسازیم

فرض می کنیم معادله خطی بوده S=AX

ممکنه نویز هم داشته باشد S=AX+e

خلاصه کلاس حضوری مهندسی تجارت الکترونیک دکتر هاشمی ۹۲/۰۹/۲۰

نمودار فرایند کلی مهندسی و ایجاد سیستم های تجارت الکترونیک

در تمرین ها به یاد داشته باشید :

در تجارت بین خریدار و فروشنده تعامل وجود دارد

عملی تجاری محسوب می شود که رقابت در آن باشد.

مقالاتی در مورد :

در بحث توصیه گر ها

قیمت ها

ترتیب نمایش کالا ها

طراحی ابزار های کاربری در ECS

ایجاد کمپین تبلیغاتی در وب سایت های دیگر

مراحل طراحی سیستم تجارت الکترونیکی

– طراحی محتوای الکترونیکی ECS

– طراحی ابزار های کاربری

– طراحی شبکه ارتباطی و خدمات دسترسی

– طراحی خدمات الکترونیکی

– طراحی زیر ساخت پردارشی

– طراحی سناریو های خدمت رسانی به کاربران

ابزار کاربری تاثیر گذار بر شکل و نحوه ایجاد محتوا برای موضوعات نیاز کاربران

طراحی ابزار کاربری در بیشتر موارد شامل انتخال از بین ابزار های موجود می دانیم

– موبال / اندروید / با صفحه نمایش ۷٫۷ / ۳G –> سیار و همراه کاربر + محدودیت نمایش محتوا

– کامپیوتر رومیزی / Win 7 / صفحه نمایش ۱۵اینچ / شبکه ۱Gig –> ثابت + عدم محدودیت در نمایش محتوا

می توانیم چند ابزار هم استفاده کنیم

مراحل طراحی ابزار کاربری

۱- تعریف شرایط والزامات هر کاربر در درسترسی به محتوای مورد نیاز

۲- بررسی و تعیین طیف ابزار های کاربری موجود و قابل استفاده

۳- انتخاب ابزار مناسب برای هر دسته نیاز کاربران تجاری

خلاصه درس حمل و نقل هوشمند – دکتر قطعی – ۹۲/۰۹/۱۹

الگوریتم بهترین مسیر بین دو گره

تلاش های متفاوتی در این زمینه انجام شده

ولی زمان زیادی می برد

باید در زمان معقول بدست بیاید

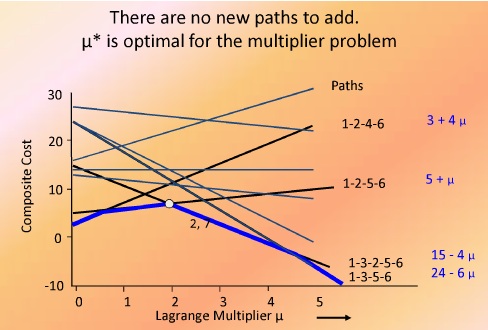

بهترین مقدار w را پیدا می کنیم

میو = ۱٫۵ پیشنهاد شده

دوباره برای این مسیر Cp و Tp را محاسبه کردم

خط جدیدی بدست آمده

فضای w که کران پاین با رنگ آبی نمایش داده شده ایت

لاگرانژ برابر ۲ شده در ضریب لاگرانژین گذاشتیم

مقدار لاگرانژین بهینه همان ۲ بدست می آید

بنابر این با ۲ بار تکرار لاگرانژ مساوی دیگر الگوریتم را متوقف می کنیم

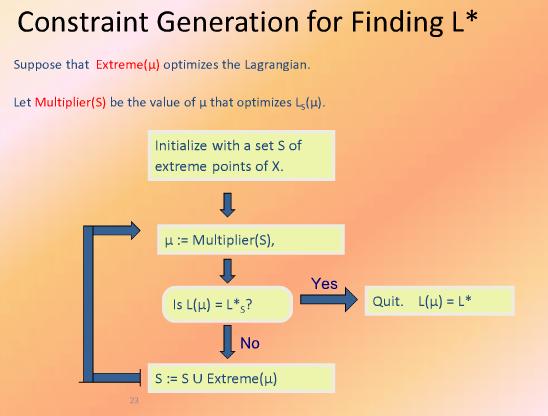

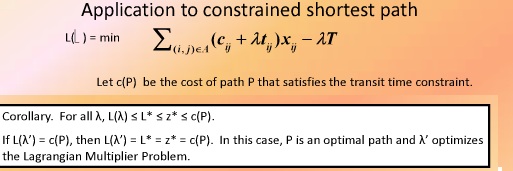

[image lagrange ]

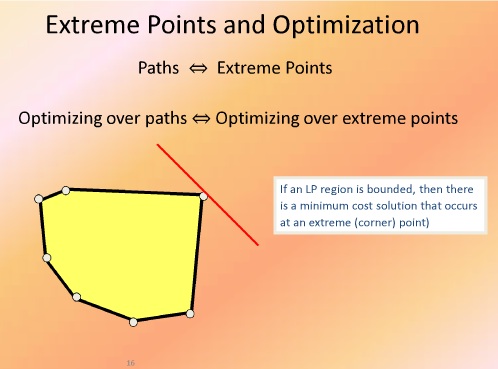

سوال : ایا لاگرانژین ربطی به LP هم دارد یا نه

یک تئوری :

فرض می کنیم یک تابع خطی داریم که می خواهیم شبیه سازی کنیم

یا این مساله جواب بهینه دارد یا ندارد

اگر جواب بهینه داشته باشد مثلا عدد ۱۰۰ یا ۲۰۰ باشد

این امکان هست که یک نقطه گوشه ای وجود دارد که جواب بهینه باشد

[image extreme points and optimization]

در مسایل شبکه نقاط گوشه ای جایشان را می دهند به مسیر ها

بنابراین ما مسیر ها را مانند گوشه ها در نظر می گیریم

در شبکه ها هم جواب بهینه مانند نقاط گوشه ای پیدا می شود مانند LP

در مسایل ITS انتخاب هایی گسسته داریم

یا به صورت Integer

پس فضای شدنی و فضای جواب به صورت چند وجهی نیست بلکه مانند نقاط گسسته داخل فضا هست

در شکل خارجی ترین نقاط را به هم وصل می کنیم تا شکل چند وجهی محدب بست بیاید

این چند وجهی به ما کمک می کند که جواب بهینه تقریبی را بدست بیاوریم

پس یک ارتباط دو طرفه برقرار می شود

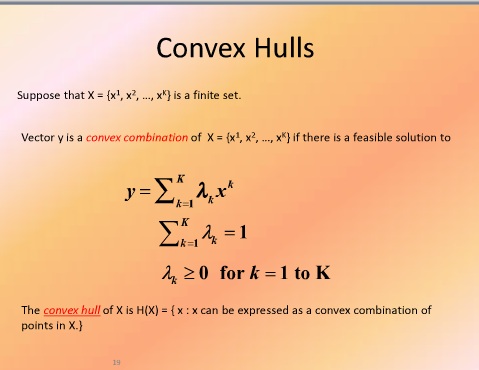

در تئوری می توان ثابت کرد x1 تا xn نقاط راسی ما باشند بقیه نقاط به صورت ترکیبی از نقاط قابل نوشتن هست

Convex Hulls

در لاگرانژین مینیمم سازی cx

مساله لاگرانژ تبدیل به مساله لاگرانژ روی نقاط راسی تبدیل می شود

در این حالت یک کران بالا برای w ها پیدا می شود

بهترین مقدار w با این شرایط محاسبه می شود

مقدار بهینه *L پیدا می شود

مقدار بهینه لاندا ها پیدا می شود

البته مسایل لاگرانژین بخاطر کاربرد های متنوعی که در بهینه سازی دارد خیلی ها به دنبال راهکار هایی برای بهبود هستند که الگوریتم های لاگرانژین محکم و مستدل هستند

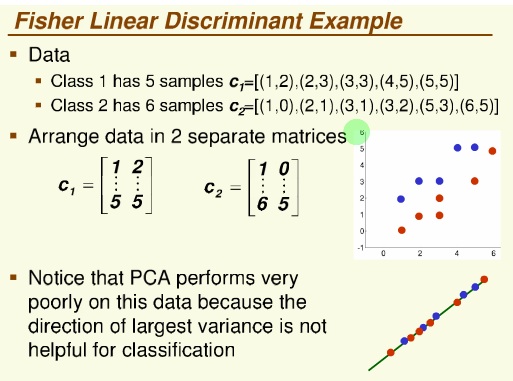

روش فیشر

پراکنش داده ها

داده ها را از دو بعد به یک بعئ می خواهیم map کنیم

فقط جهت بردار مهم است

معیار یا جهت مناسب ، جهتی است که جدا پذیری دو کلاس زیادباشد

و تقسیم بر پراکنش درون کلاسی هم می کنیم (که هر چه کمتر باشد بهتر است )

نام این مساله : مساله مقدار ویژه تعمیم یافته

این نمونه معمولا در امتحان می آید

یا مفهوم این که Fisher با PCA جه فرقی می کند

نمونه ای که ممکن است در امتحان بیاید

معمولا دوستان در اینورس کردن ماتریس اشتباه می کنند

جهتش هم می خواهیم که رسم کنید

——————————–

روش های خوشه بندی

فرض می کنیم دستگاهی برای دسته بندی و بسته بندی ماهی داریم

برای تفکیک ماهی ها از روش های خوشه بندی می خواهیم استفاده کنیم

اولین قدم data Gathering هست – طبقه بندی اطلاعات اولیه جمع آوری شده

خیلی از مسایل خوشه بندی تعبیر Geo metric دارند

اگر بتوانیم Rule برایش تعریف کنیم

آقای فیشر اولین بار مساله pattern Recognition را حل کرد و داده های IRIS رو مطرح کرد

قانون که می گذاریم باید برای داده های بعدی هم خوب کار کند

هر چه مدل ساده تر باشد احتمال اینکه برای داده های بعدی هم کار کند محتمل تر است

over fitting

به صورت simple از هم جدا کنیم

Predictive Accuracy

صحت پیش بینی

Accuracy صحت : تعداد صحیح ها تقسیم بر تعداد کل نمونه ها

خطا : تعداد اشتباهات تقسیم بر تعداد کل نمونه ها

روش k-fold :

داده ها را به دو قسمت تقسیم می کنیم

داده های train و داده های test

یک مدل را بر اساس داده های Train می سازیم و test را با آن آزمایش می کنیم

داده ها را به k قسمت مساوی تقسیم می کنیم

قدم اول : مدل را می سازم و با قسمت k ام خطای مدل را بدست می آوریم

قدم دوم : k-1 را Train در نظر می گیریم و باز خطا را بدست می آوریم

یک مقاله به صورت تجربی (imperical ) بخش ها را به ۱۰ قسمت تقسیم کردند

و ما هم اکثر مسایل رو ۱۰-fold می گوییم

Nearest Neighbor Classifier

هر داده جدیدی که آمد فاصله اش را با کل داده های قبلی حساب کن ، سپس sort کن

کمترین فاصله ها اکثریت را پیدا می کنیم

جزء روش های Lazy محسوب می شود چون خیلی هزینه بر هست ( با محاسباتی زیاد

هست )

جلسه بعد nearest neghbor را می گوییم

خلاصه مباحث درس مهندسی تجارت الکترونیک – خانم قوامی پور

فاز دوم تمرین تا هفته دیگه مهلت دارد

مقاله : اونهایی که آپلود کردند

برای پروژه تحقیقاتی معمولا تا بعد از امتحان فرصت دارید

PGFD را به صورت پیوست بفرستید

مقاله در مورد hidden markov chain کسی کار کرده ؟ ( از بچه های کلاس کسی کار نکرده بود )

خروجی فعالیت های بازار یابی : خروجی حاصل عمل بازاریابی – علاقه مندی هر کالا چه چیزی هست

توضیحات روی فاز دوم تمرین :

در شیت اول ماتریس جریان کار ، هر کدام از ستون های برای چه هدفی ایجاد شده اند

مراحل انجام فعالیت جزء به جزء نوشته می شود

برای تکمیل شیت دوم بهتر است که PGFD را از قبل کشیده باشید

برای ۵ تا فعالیت که PGFD دارید این شیت دوم را کامل کنید

نوع جریان : داده ، کالا ، مالی می تواند باشد

موضوع جریان :

ابزار جریان : وسیله ای که توسط آن جریان اتفاق می افتد ، مثلا داده در چه فرمی ارسال شده ، یا کالایی که توسط خط هوایی ارسال شده

می توانید فعالیت ها را جدا در نظر بگیرید یا اینکه در یک شیت بکشید

برای فعالیت هایی که تمام الکترونیکی یا نیمه الکترونیکی هستند را بیاورید ، چون فعالیت های غیر الکترونیکی کمکی به سیستم شما نمی کند.

مثلا یک مشتری keyword وارد سیستم می کند

از کاربر به ECS – نوع جریان : داده – موضوع محتوای جریان

حتما موضوع مقاله را بفرستید

دانشجویان گرامی:

ارزیابی دروس از طریق وب از تاریخ ۹۲/۰۹/۱۶ تا ۹۲/۱۰/۰۲ اجرا می گردد. دفتر نظارت و ارزیابی توجه دانشجویان محترم را به نکات زیر جلب مینماید.

دقت در پاسخگویی به سئوالات، مشارکت همه جانبه و ارائه پیشنهادات سازنده در بهبود کیفیت آموزش و امر تدریس دانشگاه بسیار مؤثر می باشد.

نظرات شما بدون ثبت اطلاعات فردی ذخیره و مورد ارزیابی قرار خواهد گرفت.

خواهشمند است شخصاً اقدام به انجام ارزیابی نمایید.

تذکر: ارزیابی کلیه دروس ثبت نامی برای تمامی دانشجویان الزامی میباشد و در صورت عدم انجام، مشاهده کارنامه در پورتال آموزشی امکانپذیر نخواهد بود.

از همکاری شما متشکریم

دفتر نظارت و ارزیابی و برنامه ریزی دانشگاه

خلاصه درس داده کاوی – دکتر محمد پور – ۹۲/۰۹/۱۸

برنامه ارائه مقالات کنفرانس داده کاوی در لینک ذیل قرار دارد:

http://dl.irandatamining.com/users/uploads/BarnamehConference.pdf

امروز در مورد محک های ارزیابی تجربی صحبت می کنیم

سه روش مشهور داریم

که معروفترینشان Cross validation هست

اگر از روش هایی استفاده می کنیم فقط دستورش را ببینیم در clementine هر کدام یک مدل با فرض های مختلفی هستند

و بهتر بودن هر کدام مشخص نیست

با اینکه همه خوشه بندی انجام میدهند ولی ممکن است در ارزیابی موفق نباشند

انتخاب مدل مناسب کار بسیار سختی است

در مرحله ارزیابی مدل را تست می کنیم

از داده ها استفاده می کنیم ببینیم چقدر می تواند پیشبینی را انجام دهد

اگر روشی جدید ابداع کردید باید صحت پیشبینی آن از بقیه روشهای بهتر باشد

قابل تعمیم بودن

قابل تفسیر بودن : روش ما باید قابل تفسیر باشد

سادگی

کیفیت نشانگر ها Domain-Dependent quality indicators

————

چطور خطا را حساب می کنیم

با تابع Loss Function

ساده ترین آنها Zero Loss Function است

امید Loss میشه Risk

در مساله خوشه بندی خیلی ساده تعداد ۱ ها بخش بر n می شود

در خوشه بندی وقتی می خواهیم Evaluate کنیم

Nc تعداد داده های درست کلاس بندی شده

Nt تعداد کل

درصد درست کلاس بندی شده هاست

e درصد اشتباه کلاس بندی شده هاست

C اپسیلون داد ها

هزینه برای داده های بد کلاس بندی شده ها

miss clasification Cost

اگر بخواهیم به صورت نظری

COLT typical research questions

با داده های مثال از پیش تست شده روش جدید را می توانیم تست کنیم

چرا ؟ چون باید در بدترین شرایط تست شود

Emprical evaluation

سعی و آزمون

مثلا به تصادف چند داده را انتخاب کنیم

Resampling : ( باز نمونه گیری ) چند بار به صورت تصادفی انتخاب میکنیم میانگین آنها را محاسبه می کنیم

BootStrap : Resampling با جایگذاری است

Hold out برای داده های بزرگ کاربرد دارند

k-fold Cross Validation :

خیلی ها اتفاق نظر دارند که این روش خیلی بهتری است

در این روش جای داده های train و test عوض می شوند

۱- شکستن داده ها ( به صورت تصادفی ) مثلا یک سوم test دو سوم tranining

۲-

۳- داده هایی را که برای تست در نظر گرفتیم خطا ها را حساب می کنیم

——————————–

در Hold-out ما overlapping داریم

ولی در Cross-validation بحث overlapping را نداریم

اگر بخواهیم دو الگوریتم را با هم مقایسه کنیم

از روش های آماری می توانیم استفاده کنیم

خلاصه جلسه تدریس یار داده کاوی – ۹۲/۰۹/۱۷

برای روابط می توانیم از روش های آماری مختلف استفاده کنیم

مثل رگرسیون

می توانیم از جداول دو بعدی (توافقی) هم استفاده کنیم

اگر متغیر هایی که ما می خواهیم بررسی کنیم هر دو کمی باشند می توانیم از ضرایب همبستگی

پیرسون استفاده کنیم

بعضی مواقع روابط بین متغیر ها هر دو ممکن است کمی نباشند

و یکی از آنها کیفی ترتیبی باشد

مثلا در آمد افراد با سن افراد نسبتی را بدست بیاوریم

رابطه بین دو متغیر را با پیرسون مشخص می کنیم

ضریب همبستگی فقط شدت و جهت متغیر ها را نشان می دهد

چه رابطه ای بین متغیر مستقل و ثابت وجود دارد ؟

کدام متغیر روی دیگری اثر می گذارد ؟

آیا سن روی در آمد تاثیر می گذارد ؟

سن به عنوان متغیر ورودی ، تاثیر گذار

در آمد به عنوان متغیر تاثیر پذیر

به این دلیل که درآمد که نمیتواند روی سن تاثیر بگذارد

بنابراین از روش های رگرسیونی استفاده می کنیم

در روش های رگرسیونی متغیر وابسته چیست ؟

متغیر وابسته ما مقدار کمی است

اگر متغیر وابسته بین صفر و یک باشد رگرسیون معمولی نمی توان گرفت

ممکن است رگرسیون لوجستیک دو حالتی را انتخاب کنیم

اگر پاسخ کمی و عددی باشد ممکن است رگرسیون پواسن را انتخاب کنیم و یا رگرسیون دو جمله

ای منفی

اگر متغیر کیفی ترتیبی باشد …

اگر متغیر وابسته عددی باشد …

در رگرسیون خطی آیا فرمولش مشخص است؟

فرم رگرسیون خطی را باید مشخص می کنیم

در فیلد های کمی سرشماری می تواند به عنوان متغیر target استفاده شود

بعضی از پیش فرض ها ذهنی هستند

مثلا در مناطق مرفه نشین خانه ها بزرگ تر ، انرژی بیشتری مصرف می کنند

اگر متغیر ما تحصیلات باشد و به آن کد اختصاص داده باشیم باید آنرا به متغیر های مجازی تبدیل

کنیم

مثلا متاهل =۱ و مجرد=۰ قرار می دهیم

برای تحصیلات فوق دیپلم =۰ یا ۱ ، لیسانس = ۰ یا ۱ ، فوق لیسانس =۰ یا ۱

(فقط صفر و یک )

مثلا برای در آمد

income = a + B1.Age+B2.Edj1+B3.Edj2+B4

جدول آنالیز واریانس را در خروجی می بینیم

برای مثال در فایل دیتای نمونه telco را کار می کنیم

در گزینه Expert گزینه include را می زنیم

در گزینه output علاوه بر دو تیک بالایی که خلاصه مدل و اطلاعات مربوط به ضرایب رگرسیونی را می دهد ضرایب جزیی و نیمه جزیی را می دهد

در کرکره analyze می زنیم

اینکه کدام از یک از متغیر ها در مدل تاثیر دارد نشان داده میشود

در کرکره summary خلاصه را می بینیم

در کرکره Advanced گزینه های پیشرفته را داریم

در جدول correlations ضرایب همبستگی متغیر ها با هم نشان داده می شود

متغیر هایی که خارح شمد و داخل شدند در جدول Variables Entere/Remoed نشان داده می شند

در model Summary نشان دهنده شدت همبستگی همه متغیر های وابسته با متغیر مستقل را نشان می دهد

به فرم درصدی نشان داده می شود

R square ضریب تعیین کننده است ، هر چه به ۱ نزدیک تر باشد نشان دهنده این است که متغیر ها خوب است

و هر چقدر به صفر نزدیک باشه نشان دهنده خوب نبودن متغیر های وابسته هست

آماره durbin-watsin هر چقدر از ۲ فاصله بگیرد ، ناخالصی را نشان می دهد

اگر آماره durbin-watsin بین ۰ و ۲ باشد نشان دهنده خود همبستگی مثبت است

اگربین ۲ تا ۴ باشد یعنی بین متغیر ها نتوانسته رابطه خوبی را تشخیص دهد

جدول آمالیز واریانس ANOVA

آیا مدل رگرسیون که انتخاب کردیم مدل مناسبی هست ؟

ویژگی های آماری

ستون درجه آزادی

ستون آماره F

sig – significant level سطح معنی داری (اگر از ۰٫۵ کتر باشد نشان دهنده این است که متغیر ضریبش مخالف ۰ است )

می خواهیم ببینیم که بیشترین تاثیر را دارد ستون بتا را می بینیم

صرف نظر از اینکه مثبت یا منفی باشد ، عدد نشان دهنده بیشترین تاثیر را نشان می دهد

zero-order

partial ضریب همبستگی سن و درآمد را وقتی مابقی متغیر ها هم اثر را گذاشتند و این اثر را حذف کردیم

Part ضریب همبستگی نیمه جزیی بین سن و در آمد ، همه متغیر ها روی متغیر وابستهاثر گذاشتند و ثابت مانده اند ( حذف نکردیم )

Col

بعضب مواقع بین متغیر ها رابطه رگرسیونی اجرا می کن تا بین متغر ها رابطه همخطی نباید وجود داشته باشد

ستون vif باید زیر ۱۰ باشد

در جدول بعدی مقادیر ویژه و مقادیر شرطی را مطرح کرده

شاخص شرطی هم باید زیر ۳۰ باشد

در قسمت variance proportions

وقتی عرض از مبدا اثر می گذارد سن دیگر نقش موثری ندارد

جدول آخر مقادیر پیش گویی شده را نشان می دهد

مشاهدات واقعی منهای جواب پیشگویی

SVM

Support vector Machine

از روشهای هوش مصنوعی است مثل درخت های تصمیم گیری بر اساس یک متغیر هدف خاص که

ترجیحا از جنس کیفی باشد

داده ها را می خواهیم پیشگویی کنیم

ستون ID را بدون فرمت می کنیم (Typeless)

متغیر اصلی و هدف class هست

از پارامتر عرض ازمبدا که پیش فرض را ۱۰ گرفته است استفاده می کنیم

مهمترین متغیر های موثر را به ما نشان میدهد

خلاصه درس تدریس یار خوشه بندی – ۹۲/۰۹/۱۶

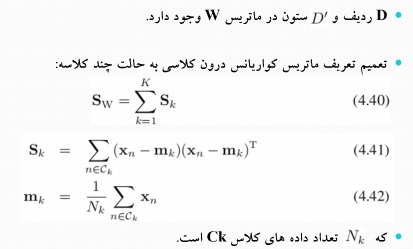

فیشر دو کلاسه را جلسه قبل گفتیم

هم واریانس بین کلاسی و هم واریانس درون کلاسی را محاسبه می کردیم

از لاگرانژ استفاده نکردیم و مستقیم مشتق گرفتیم ( چون صورت و مخرج با هم ساده می شد)

که رابطه ۴٫۲۹ بدست آمد

برای خوشه بندی کافیست روی داده ها یک میانگین های تصویر شده را محاسبه کنیم

متوسط میانگین های تصویر شده

——————————————

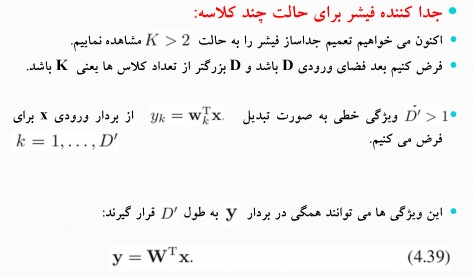

فیشر چند کلاسه :

مثلا روی داده های IRIS که چهار بعدی هست که می خواهیم به دو یا سه بعد کاهش می دهیم

فیشر حالت چند کلاسه – تعداد ابعاد از D بعد به به بیشتر از یک بعد و کمتر از D بعد هست

می خواهیم ‘D ویژگی خطی بدست بیاوریم

اگر ۴ بعد داریم می خواهیم به دو بعد کاهش بدهیم یعنی ‘D مساوی ۲ هست دوبردار باید داشته باشیم w1 و w2 داریم

رابطه ۴٫۳۹

S Within جمع روی k کلاس واریانس درون کلاسی

یک ماتریس نسبت به دو کلاسه بیشتر داریم به اسم :

S total ماتریس کواریانس کل نمونه ها ( پراکندگی کل داده ها صرف نظر از کلاسشون )

ماتریس کواریانس کل را می توان به صورت جمع ماتریس درون کلاسی و ماتریس بین کلاسی نوشت

متوسط هر کلاس با متوسط همه کلاس ها S Bitween

Trace : اعضای قطر اصلی را با هم جمع کنیم

برای اینکه مساله فیشر را حل کنیم Sw , Sb را باید محاسبه کنیم

S^-1w*Sb

y1 , y2 در کنار هم بردار دو بعدی کاهش یافته می شود

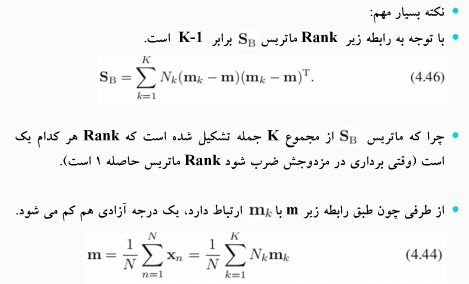

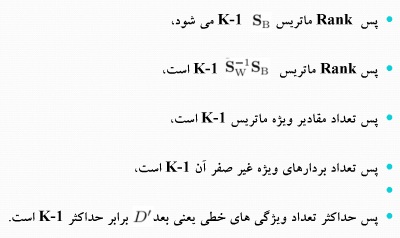

نکته : Rank ماتریس ( درجه ماتریس )

می خواهیم ببینیم که حداکثر به چند بعد می توانیم کاهش بدهیم

هر ماتریس درون کلاسی Rank آن ۱ است

و k تا ماتریس را که با هم جمع می کنیم Rank آن K می شود

چون تمام متوسط ها به m ربط پبدا کردند Rank k-1 می شود

پس برای IRIS به دو بعد می توانیم کاهش دهیم چون ۳ تا کلاس دارد

——————————–

تمرین : فیشر ۳ کلاسه IRIS را انجام دهید

——————————–

تمرین مهم :

موضوع اول : K-means

Search کنید در موضوعات k-means که به آن VQ یا LBG هم می گویند

می خواهیم انواع حالت های آنرا بگویید ( weighted VQ )

مقاله های جدید را پیدا کنید

۱- انواع روش های VQ را بگویند

۲- روش دوم VQ را بهبود دادند

۳- روشهای VQ را Weighted را گفته اند

Wave Distance – چه تابع هایی را می توان به جای Distance اقلیدسی ، معیار فاصله جدید استفاده کرده

به جای تابع نرم اقلیدسی چه تابع های دیگری را گذاشته است

ترجیحا مقالاتی را پیدا کنید که Cost Function های جدید ارائه کرده اند

————————————

موضوع GMM

————————————

موضوع Kernel

————————————

موضوع Fisher

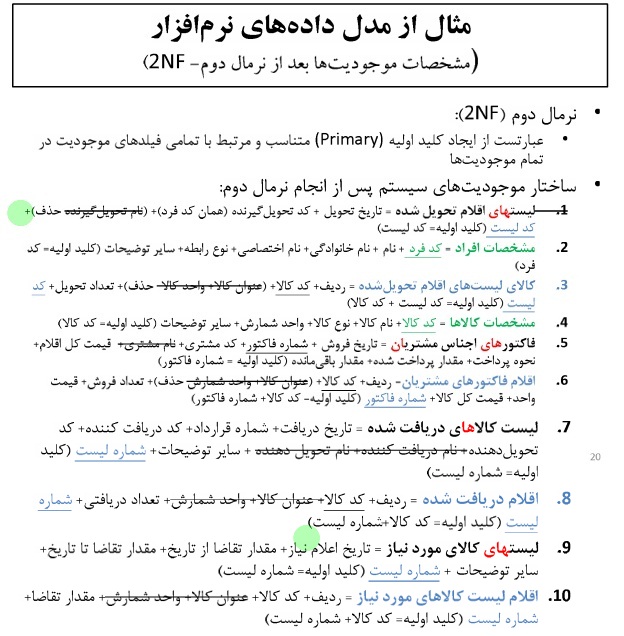

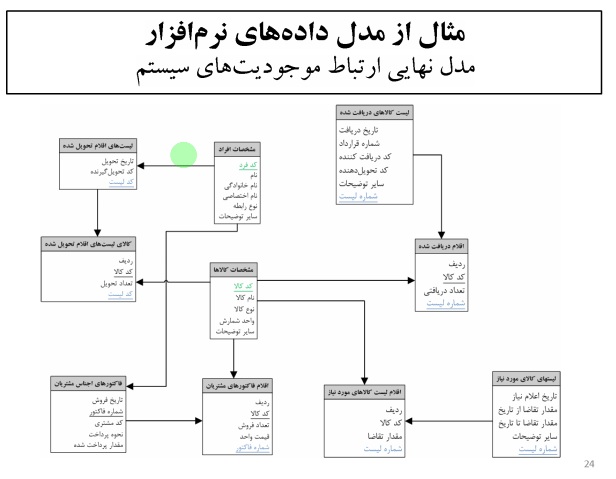

محتوای الکترونیکی

۱- موضوع –> ماهیت و موضوع –> تحلیل نیازمندی های مشخص شده

۲- شکل –> قالب و نحوه نمایش و عرضه یا دریافت محتوا

مشخص شده در هر انباره چه مقولاتی ذخیره شده است

هر عنوانی که در {} آمده، نشان دهنده این است که هر یک از موارد مشخصات مشتمل بر مجوعه ای از این داده ها خواهد بود

به ازای هر ردیف از جدول مقادیری تکرار شونده هستند

که این انباره را به دو قسمت تقسیم کرده ام

یک ارتباطی هم بینشان برقرار کرده ام

برای تمام جدول ها باید کلید اختصاصی کننده ایجاد کنم تا در تمام جدول ها یکتا باشد

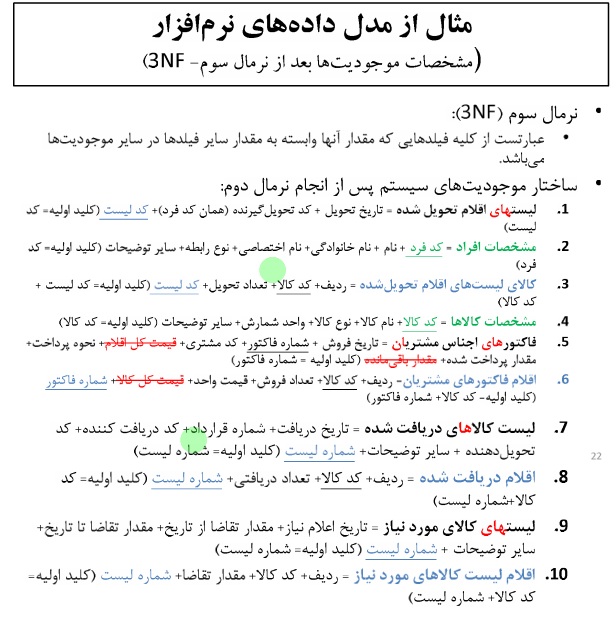

در نرمال سوم کلیه فیلد هایی که مقدار آنها وابسته به مقدار سایر فیلد ها است

جدولی را در نظر می گیریم که تک تک فیلد ها را لیست می کنیم و مشخص می کنیم هر کدام از چه منبعی استفاده می شود.

SB : System Base ( متغیر سیستمی )

DB : Database ( بانک اطلاعاتی )

MB : Momory Base ( فرمول محاسباتی در حافظه )

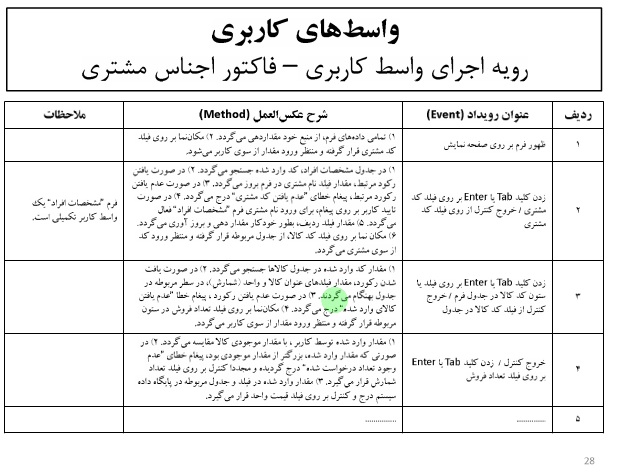

مجموعه رویداد ها و اتفاقاتی که این واسط کاربری را اعلام کند را در جدولی دیگر می آوریم Detail Design

ما بین واسط های کاربری را مدل پیمایشی داشته باشیم

مدل ریاضی انتخاب تکنولوژی

f هزینه نصب تکنولوژی هست

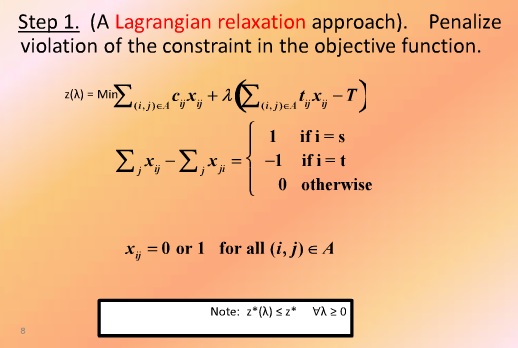

هر تصمیم گیری ITS در رفتار کاربران تاثیر می گذارد

Ci,j هزینه ای است که کاربر K پرداخت می کند تا از مبدا i به مقصد j پرداخت می کند

Xi.j مسیر بین i , j هست

برای پیدا کردن مسیر از لاگرانژ استفاده می کنم

قید ها به دو دسته تقسیم می شود ( آسان و سخت )

مثال : متغیرصفر و یک برای الگوریتم های درختی (این متغیر برای این الگوریتم متغیر آسان است)

ولی اگر الگوریتم اگر حرکت باشد متغیر صفر و یک بدرد نمی خورد و در اینجا قید سخت محسوب می شود

در این مسایل هم قید های سخت را باید حذف کنیم

باید کرانی برای جواب پیدا کنیم

لاگرانژ به جای اینکه جواب دقیق پیدا کند یک جواب تقریبی برای مساله پیدا می کند

در اینجا فقط با یک قید سخت Complicated Constrained کار می کنیم

Ci,j هزینه سفر از i به j هست

Xi,j صفر یا یک می گیریم

لاگرانژ کمک می کند تا قید سخت را در این مسایل حذف کنیم

آزاد سازی لاگرانژ

فرض کنیم که لاندا مقدار جریمه باشد

با اضافه کردن ضریب جریمه لاندا در تابع هدف قید سخت را حذف می کنیم

تابع هدف که مینیمم سازی هزینه می خواست بکند

حالا با جریمه لاندا این قید های سخت را هم حذف می کنیم

حالا جریمه چقدر باشد تا جواب معقول بدست بیاوریم ؟

آیا مکانیزمی داریم که بعد از حذف قید های زاید جواب بهینه را پیدا کنیم ؟

بله لاندا را باید ثابت فرض کنیم

یک عدد ثابت را در یک تابع مینیمم سازی اضافه یا کم کنیم در جواب مساله تاثیر حاصل نمی شود

اول منفی لاندا تی را در نظر نمی گیریم

چجوری میشه لاندا را کم و زیاد کرد

آیا مقادیر بهینه لاندا را پیدا کرد؟

برای پاسخ به این سوال تست عددی را محاسبه می کنیم

در ابتدا لاندا را صفر در نظر می گیریم ( بدون در نظر گرفتن ترافیک یا شلوغی مسیر)

C1,6 : که مسیر ۱ به ۲ به ۴ به ۶ کوتاه ترین مسیر هست که با ۳ مسیر به مقصد می رسیم

T1,6 : ولی زمان سفر ۱۰+۱+۷ می باشد

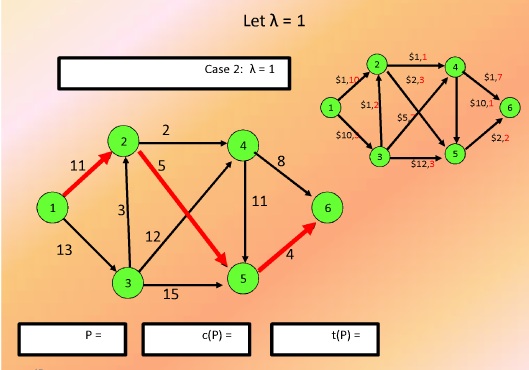

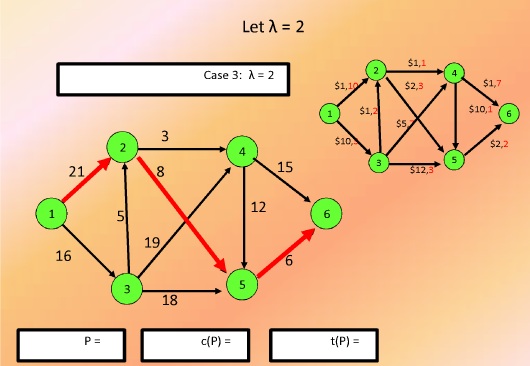

حالا جریمه لاندا را اضافه می کنیم که به ازای لاندا مساوی ۱ با توجه به مقادیر ثابت یالها هزینه رسیدن به مقصد را پیدا می کنیم

(Ci,j+(Lamba)(Ti,j

همین کار را گسترش می دهیم با لاندا مساوی ۲ که می بینیم بهبودی مشاهده نمی شود

همین کار را برای مقادیر دیگر لاندا هم انجام میدهیم

در این شکل به ازای مقادیر مختلف لاندا هزینه های مسیر مشاهده می شود

اگر می توانستیم به ازای تمام مقادیر جریمه های لاندا جواب بهینه را پیدا کنیم ، خیلی خوب بود

ولی نمی توانیم تمام مقادیر لاندا را پیدا کنیم

پس لاندا را باید به صورت رندوم یا به صورت غیر خطی پیدا کنیم

اگر متناسب با L لاندا که یک عدد ثابت حقیقی هست جوابی را پیدا کنیم P جواب مساله می شود

در مساله لاگرانژین درسته که هدف ما ماکزیمم سازی L میو هست

اگر یک جواب بهینه پیدا کردیم که مساوی L میو شد بهترین حالت رخ داده است

ولی اگر پیدا هم نشد به عنوان جواب تقریبی قبول می کنیم

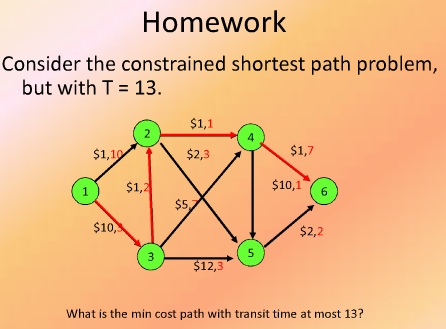

به عنوان homework مساله را با T=13 پیدا کنید